Nỗi sợ deepfake nguy hiểm hơn chính deepfake

Các hãng tin đang lo ngại trước mối nguy hiểm của deepfake và bỏ qua lợi ích mà công nghệ này mang lại.

Tiến sĩ Aya Yadlin-Segal, giảng viên cao cấp tại tại Trường Cao đẳng Học thuật Hadassah (Israel), chia sẻ quan điểm của ông về deepfake:

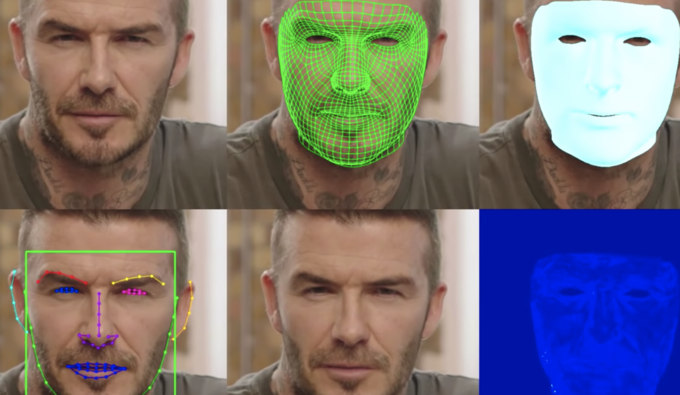

“Nội dung được tạo từ AI – trong đó có các văn bản, âm thanh và đặc biệt là video deepfake – hình thành nên cái được giới truyền thông gọi là “mặt trận mới” trong cuộc chiến chống lại tin giả. Ở đó, các lực lượng trực tuyến được thành lập với mục đích lan truyền thông tin sai lệch, sản xuất hình ảnh nhạy cảm , hoặc chống phá các hệ thống chính trị. Phát hiện nội dung giả mạo ngày càng khó, nếu không muốn nói là không thể, đối với người chưa có kinh nghiệm.

Nhìn chung, đa số các bài báo về chủ đề này đều nói deepfake, cùng với các công nghệ AI khác, đã tồn tại và sẽ phủ bóng đen của khủng bố công nghệ lên xã hội.

Một phần trong những bài báo ấy cho rằng loài người sẽ lạc hậu và thua trong các trận chiến với máy móc. Viễn cảnh như trong phim Black Mirror sẽ chẳng là gì so với sự hủy diệt thật sự của công nghệ. Nghiên cứu của tôi cùng một đồng nghiệp tại Đại học Haifa (Israel) chỉ ra phần lớn khía cạnh báo chí đề cập đến deepfake đều là tiêu cực. Họ nhấn mạnh sự hủy diệt, thiệt hại và khủng hoảng ảnh hưởng tới nhân loại do deepfake.

Tuy nhiên, cần nhìn nhận vấn đề một cách cụ thể. Trước hết, deepfake đặt ra câu hỏi về cách chúng ta tiếp nhận tính xác thực. Tài liệu thực tế, báo cáo các sự kiện và thậm chí cả phương tiện phản ánh sự thật cũng bị đặt nghi vấn. Thông thường, rất khó xác định một đoạn ghi âm hay video vừa xem là thật hay giả và liệu chúng có phải là sản phẩm của AI hay không.

Các giác quan – nguồn cung cấp kiến thức cho con người bao đời nay – trở nên lạc hậu theo một nghĩa nào đó. Ngay cả với kiến thức hiện có cũng không khiến con người hoàn toàn tự tin để phân biệt nội dung nào do AI tạo ra. Bên cạnh đó, nhiều kẻ lạm dụng công nghệ AI vào mục đích xấu, cố tình chỉnh sửa văn bản và hình ảnh nhằm tạo xung đột chính trị hoặc phát tán nội dung nhạy cảm.

Video đang HOT

David Beckham có thể nói nhiều ngôn ngữ khác nhau nhờ deepfake giọng nói.

Bên cạnh những mối nguy kể trên, mặt tích cực của deepfake lại bị báo chí toàn cầu bỏ qua. Thay vào đó, họ chọn nhấn mạnh các khía cạnh giật gân, đáng sợ của deepfake.

Thực tế, deepfake hoạt động dựa trên những công nghệ vốn đem lại nhiều mặt tích cực và hiệu quả cho con người. Ví dụ, trong lĩnh vực chăm sóc sức khỏe, các nhà nghiên cứu đã tạo ra hình ảnh chụp cộng hưởng từ (MRI) não để huấn luyện thuật toán chẩn đoán bệnh. Ngoài ra, trong lĩnh vực ung thư và bệnh Alzheimer, các nhà nghiên cứu đã phát triển hệ thống chẩn đoán dựa trên dữ liệu bệnh nhân giả. Điều này giúp giảm các xét nghiệm xâm lấn, đồng thời bảo vệ quyền riêng tư về hồ sơ y tế của bệnh nhân.

Tương tự, công nghệ deepfake giọng nói hỗ trợ tạo và lan truyền các thông điệp xã hội quan trọng. Ví dụ, David Beckham tình nguyện tham gia chương trình giúp nâng cao nhận thức về bệnh sốt rét. Trong video tuyên truyền, siêu sao bóng đá truyền tải thông điệp bằng nhiều ngôn ngữ nhờ sự trợ giúp của deepfake, bởi Beckham chỉ thực sự nói một ngôn ngữ. Các ngôn ngữ còn lại được tổ chức Malaria must die sản xuất và ghép vào video gốc, dưới sự hỗ trợ của hãng truyền thông Synthesia.

Vậy tại sao hầu hết các phương tiện truyền thông vẫn nhắm vào mặt tiêu cực, nguy hiểm của deepfake? Vấn đề này không hề mới. Trong lịch sử, nhiều công nghệ mới khi được giới thiệu đều nhận phải ý kiến trái chiều và sự e ngại. Chẳng hạn, máy in khi ra đời đã được coi là mối nguy hiểm và các nhà thờ lo ngại sẽ mất đi các tín đồ sùng đạo. Tương tự, TV cũng bị cho là gây mất đoàn kết xã hội và phá hoại lối sống gia đình truyền thống. Với deepfake, nó mang tiếng bóp méo sự thật, khiến mọi thứ trở nên không đáng tin cậy và làm suy đồi đạo đức nhân văn.

Phải thừa nhận deepfake đang bị lạm dụng, nhưng cần có cái nhìn đầy đủ, đa chiều đối với vấn đề phức tạp. Deepfake quả thực đáng sợ. Nó khiến con người hoài nghi và tự vấn về tính xác thực của thông tin. Công nghệ AI vẫn chưa được phát triển toàn diện để nhận biết deepfake. Dẫu vậy, cần nhớ chính con người tạo ra deepfake, đóng góp nội dung vào đó, hoặc tiếp nhận tin giả và lan truyền trên các trang mạng xã hội mà không hề suy nghĩ.

Deepfake nhắc nhở chúng ta cần tỉnh táo và chín chắn hơn trong việc chắt lọc, tiếp nhận thông tin”.

AI do Musk hậu thuẫn nguy hiểm hơn deepfake

GPT-3, công cụ tự động tạo văn bản dựa trên AI, có thể bị lợi dụng để lan truyền văn bản giả mạo, khó phân biệt trên môi trường Internet.

Năm 2017, vài tháng trước khi qua đời, thiên tài vật lý Stephen Hawking đã mô tả sự xuất hiện của AI là "điều tồi tệ nhất trong lịch sử văn minh của loài người". Chỉ ba năm sau, với sự ra đời của GPT-3, các chuyên gia cho rằng công nghệ AI này đang chứng minh lời của Hawking là đúng.

Các hệ thống AI ngày càng thông minh. Ảnh: Medium.

GPT-3 là mô hình ngôn ngữ sử dụng deep learning để tạo ra văn bản có độ tin cậy rất cao. Đây là công nghệ thuộc thế hệ thứ ba trong dự án GPT được phát triển bởi OpenAI - phòng nghiên cứu phi lợi nhuận đặt ở San Francisco (Mỹ), được tài trợ bởi Elon Musk, Peter Thiel và nhiều nhà đầu tư khác ở Thung lũng Silicon.

Theo công bố mới đây, GPT-3 có thể soạn thảo nội dung tự nhiên như người viết. Hệ thống này được OpenAI "học" từ cơ sở dữ liệu khổng lồ gồm hàng triệu nội dung tiếng Anh ở nhiều lĩnh vực. Khi người dùng đưa ra yêu cầu, AI sẽ lọc các nội dung liên quan, thu thập các tham số rời rạc rồi kết hợp với nhau, cuối cùng trả về văn bản hoàn thiện, phù hợp với "đề bài".

GPT (Generative Pre-training Transformer) đầu tiên ra mắt năm 2018, sử dụng mô hình ngôn ngữ tổng quát bao gồm hai mạng thần kinh tự cạnh tranh nhằm hoàn thiện lẫn nhau. Khi đó, GPT đã tự tạo ra những đoạn văn bản hoàn chỉnh. Thế hệ thứ hai, GPT-2, trình làng tháng 2/2019 có độ hoàn thiện cao hơn, đến nỗi Musk từ chối công bố vì sợ nó có thể đăng tin giả lên Internet.

GPT-3 là thế hệ thứ ba, ra mắt hồi tháng 5 vừa rồi và chính thức có mặt dưới dạng giao diện lập trình ứng dụng (API) cho các nhà phát triển cuối tháng 7. Hệ thống sử dụng cơ sở dữ liệu với 175 tỷ tham số, lớn gấp nhiều lần so với 1,5 tỷ tham số của GPT-2 và 17 tỷ tham số từ siêu máy tính chuyên về AI của Microsoft.

GPT-3 mạnh hơn 115 lần so với GPT-2, đồng nghĩa rằng nó thông minh hơn và có khả năng tạo ra văn bản không khác gì con người. Bên cạnh đó, nó còn có thể dịch thuật, trả lời câu hỏi, thực hiện các nhiệm vụ cần lý luận nhanh, điều chỉnh tên miền... với tốc độ rất cao.

"Trong lịch sử, các hệ thống mô phỏng ngôn ngữ tự nhiên vẫn thiếu sắc thái thể hiện", Carolyn Rose, Giáo sư tại Viện Công nghệ Ngôn ngữ của Đại học Carnegie Mellon, nói. "Nhưng GPT-3 có vẻ khác. Dựa trên những thử nghiệm ban đầu, GPT-3 đã 'thổi bay' các mô hình hiện có nhờ bộ cơ sở dữ liệu khổng lồ mà nó học được".

OpenAI muốn thương mại hóa GPT-3 vào cuối năm nay để xây dựng chatbot cho các hệ thống trả lời tự động. Dù vậy, không ít chuyên gia đánh giá nó có thể bị lợi dụng để thực hiện mục đích khác.

GPT-3 hiện được giới chuyên môn đánh giá rất cao. Một bài báo trên MIT Technology Review mô tả hệ thống này "chất lượng đến kinh ngạc" nhưng "hoàn toàn vô tâm". Trong khi đó, David Chalmers, một triết gia người Australia, coi GPT-3 là "một trong những AI thú vị và quan trọng nhất từng được loài người tạo ra".

Tuy nhiên, các nhà khoa học cũng coi nó là mối đe dọa tiềm năng. "Các mô hình ngôn ngữ mạnh mẽ có thể bị lợi dụng để gây hại cho xã hội. Ví dụ, chúng tung thông tin sai lệch, tin giả, thư rác, lừa đảo, làm giả các quy trình pháp lý của chính phủ... lên Internet", một chuyên gia giải thích. Người này còn cho rằng, AI có thể soạn thảo nội dung tự nhiên như con người, đe dọa công việc của các nhà văn, nhà thơ, biên tập viên, người viết kịch bản, nhân viên dịch thuật...

Không giống video deepfake dễ bị lộ, giới chuyên gia gọi "textfake" - nội dung giả mạo do AI tạo ra dưới dạng văn bản - còn nguy hiểm hơn rất nhiều, do khó bị phát hiện giả mạo. "Bằng cách thêu dệt nên một mạng lưới thông tin giả mạo phức tạp để đánh lừa và thao túng con người, các nội dung 'textfake' có thể thay đổi suy nghĩ của chúng ta, nhấn chìm chúng ta vào một 'nồi canh' đầy thông tin sau lệch", Telegraph bình luận. "Nếu chúng kết hợp cả video, hình ảnh và âm thanh giả mạo, lòng tin vào nội dung trên Internet sẽ bị xói mòn".

Bên cạnh đó, những công cụ AI như GPT-3 cũng đặt ra thách thức mới cho các công ty truyền thông xã hội trong việc kiểm duyệt nội dung. Hiện tai, những công ty như Facebook đang ở vai trò là "nhà điều hành nền tảng", thường xuyên lập luận rằng họ không có nhiệm vụ phân biệt đúng sai, dù vẫn có đội ngũ kiểm duyệt riêng.

"Điều gì sẽ xảy ra nếu những lời nói dối được tạo ra, lan truyền và bình luận hoàn toàn bằng các thuật toán? Họ có trách nhiệm với những thứ này không?", một chuyên gia đặt câu hỏi.

Hawking từng nói trước mối đe dọa của AI, con người "cần nhận thức được những mối nguy hiểm, áp dụng các phương pháp quản lý và thực hành tốt nhất có thể, cũng như chuẩn bị trước cho những hậu quả của nó".

Theo Telegraph, đã đến lúc cần chế tài mới trong các lĩnh vực có thể đe dọa đến cuộc sống con người.

Công nghệ đáng sợ có thể gây ảnh hưởng nửa sau 2020  Nhiều chuyên gia lo ngại deepfake, công nghệ dùng AI để ghép khuôn mặt vào video sẽ gây ảnh hưởng lớn tới Internet và bầu cử Tổng thống Mỹ cuối năm nay. Deepfake, thuật ngữ dùng để chỉ kỹ thuật tổng hợp hình ảnh con người dựa trên trí tuệ nhân tạo là thứ vô cùng đáng sợ. Thậm chí, nó có thể...

Nhiều chuyên gia lo ngại deepfake, công nghệ dùng AI để ghép khuôn mặt vào video sẽ gây ảnh hưởng lớn tới Internet và bầu cử Tổng thống Mỹ cuối năm nay. Deepfake, thuật ngữ dùng để chỉ kỹ thuật tổng hợp hình ảnh con người dựa trên trí tuệ nhân tạo là thứ vô cùng đáng sợ. Thậm chí, nó có thể...

Con gái vừa về làm dâu tỷ phú, gia đình và hàng xóm Á hậu Phương Nhi tranh thủ làm 1 việc gây chú ý03:50

Con gái vừa về làm dâu tỷ phú, gia đình và hàng xóm Á hậu Phương Nhi tranh thủ làm 1 việc gây chú ý03:50 Khung hình quyền lực: Vợ chồng tỷ phú Phạm Nhật Vượng đón Á hậu Phương Nhi về làm dâu, biểu cảm gây chú ý00:54

Khung hình quyền lực: Vợ chồng tỷ phú Phạm Nhật Vượng đón Á hậu Phương Nhi về làm dâu, biểu cảm gây chú ý00:54 Lễ ăn hỏi của Á hậu Phương Nhi và con trai tỷ phú: Quy định nghiêm ngặt, giới hạn khách mời cực gắt00:59

Lễ ăn hỏi của Á hậu Phương Nhi và con trai tỷ phú: Quy định nghiêm ngặt, giới hạn khách mời cực gắt00:59 Mẹ Phương Nhi chiếm spotlight, không giấu được biểu cảm khi con gái về nhà chồng tỷ phú00:21

Mẹ Phương Nhi chiếm spotlight, không giấu được biểu cảm khi con gái về nhà chồng tỷ phú00:21 CLIP: Trọn vẹn khoảnh khắc gia đình tỷ phú Phạm Nhật Vượng đón con dâu từ Thanh Hóa về Hà Nội00:44

CLIP: Trọn vẹn khoảnh khắc gia đình tỷ phú Phạm Nhật Vượng đón con dâu từ Thanh Hóa về Hà Nội00:44 Thiếu gia Vingroup mang sính lễ hỏi cưới Á hậu Phương Nhi khủng cỡ nào?00:45

Thiếu gia Vingroup mang sính lễ hỏi cưới Á hậu Phương Nhi khủng cỡ nào?00:45 Ảnh nét căng bên trong lễ ăn hỏi của Á hậu Phương Nhi: Thiếu gia Vingroup chiều vợ ra mặt, 1 chi tiết để lộ mối quan hệ với bố mẹ chồng03:50

Ảnh nét căng bên trong lễ ăn hỏi của Á hậu Phương Nhi: Thiếu gia Vingroup chiều vợ ra mặt, 1 chi tiết để lộ mối quan hệ với bố mẹ chồng03:50 Thanh niên đi Mazda tát túi bụi nhân viên cây xăng ở Nghệ An: Hé lộ nguồn cơn02:08

Thanh niên đi Mazda tát túi bụi nhân viên cây xăng ở Nghệ An: Hé lộ nguồn cơn02:08 MV Tết của Đen quá hot: Đạt Top 1 Trending sau hơn 1 ngày, kéo dài chuỗi kỷ lục suốt 6 năm!05:15

MV Tết của Đen quá hot: Đạt Top 1 Trending sau hơn 1 ngày, kéo dài chuỗi kỷ lục suốt 6 năm!05:15 Lễ ăn hỏi Á hậu Phương Nhi và thiếu gia Vingroup: Cô dâu chính thức lộ diện, visual sáng sớm gây sốt00:59

Lễ ăn hỏi Á hậu Phương Nhi và thiếu gia Vingroup: Cô dâu chính thức lộ diện, visual sáng sớm gây sốt00:59 Diễn viên Hoàng Kim Ngọc: 'Tôi nghi chồng chạy vai để gián tiếp cho vợ ăn đấm'02:01

Diễn viên Hoàng Kim Ngọc: 'Tôi nghi chồng chạy vai để gián tiếp cho vợ ăn đấm'02:01Tin đang nóng

Tin mới nhất

Nâng cao và biến đổi hình ảnh của bạn bằng trình chỉnh sửa video trực tuyến CapCut

Cách đăng Facebook để có nhiều lượt thích và chia sẻ

Thêm nhiều bang của Mỹ cấm TikTok

Microsoft cấm khai thác tiền điện tử trên các dịch vụ đám mây để bảo vệ khách hàng

Facebook trấn áp hàng loạt công ty phần mềm gián điệp

Meta đối mặt cáo buộc vi phạm các quy tắc chống độc quyền với mức phạt 11,8 tỷ đô

Không cần thăm dò, Musk nên sớm từ chức CEO Twitter

Đại lý Việt nhập iPhone 14 kiểu 'bia kèm lạc'

Khai trương hệ thống vé điện tử và dịch vụ trải nghiệm thực tế ảo XR tại Quần thể Di tích Cố đô Huế

'Dở khóc dở cười' với tính năng trợ giúp người bị tai nạn ôtô của Apple

Xiaomi sa thải hàng nghìn nhân sự

Apple sẽ bắt đầu sản xuất MacBook tại Việt Nam vào giữa năm 2023

Có thể bạn quan tâm

Solskjaer trở lại ghế nóng, chuẩn bị đối đầu Mourinho

Sao thể thao

00:59:51 18/01/2025

Dọn nhà, cặp đôi vứt nhầm gần 800 triệu đồng tiền mặt vào thùng rác

Lạ vui

00:59:26 18/01/2025

Nóng: Sao nam 10X bị lừa bán sang biên giới Thái Lan được giải cứu thành công, nhìn ngón tay cái ai cũng thấy khiếp sợ

Sao châu á

23:45:51 17/01/2025

Phim cổ trang gây bão MXH nhờ lập kỷ lục 19 năm mới có 1 lần, cặp chính nhan sắc tuyệt đỉnh càng xem càng cuốn

Phim châu á

23:43:33 17/01/2025

Taylor Swift rơi vào vòng xoáy kiện tụng quấy rối tình dục

Sao âu mỹ

23:37:06 17/01/2025

Cô gái đóng 'tiểu tam' gây sốt vì ăn 20 cú tát là ai?

Hậu trường phim

23:34:02 17/01/2025

Phương Nhi làm dâu hào môn, Mai Phương - Bảo Ngọc ra sao sau Miss World Vietnam?

Sao việt

23:31:22 17/01/2025

Bí mật về quê sau 11 năm ở Hàn Quốc, chàng trai tặng bố mẹ 'món quà' bất ngờ

Netizen

23:07:07 17/01/2025

Công an Hà Nội phá đường dây mua bán thận

Pháp luật

23:03:05 17/01/2025

10 thời điểm then chốt trong cuộc xung đột Israel - Hamas

Thế giới

22:32:04 17/01/2025

Sử dụng ứng dụng hẹn hò để kêu gọi bỏ phiếu

Sử dụng ứng dụng hẹn hò để kêu gọi bỏ phiếu Trải nghiệm máy lọc không khí LG PuriCare 360 độ: Lọc hiệu quả 99% bụi siêu mịn PM0.01, thiết kế sang trọng, tinh tế

Trải nghiệm máy lọc không khí LG PuriCare 360 độ: Lọc hiệu quả 99% bụi siêu mịn PM0.01, thiết kế sang trọng, tinh tế

MobiFone nỗ lực đảm bảo mạng lưới thông suốt trong bão lũ miền Trung

MobiFone nỗ lực đảm bảo mạng lưới thông suốt trong bão lũ miền Trung Khó xác định video nhảm nhí trên mạng

Khó xác định video nhảm nhí trên mạng Phong trào QAnon bị cấm trên các nền tảng của Facebook

Phong trào QAnon bị cấm trên các nền tảng của Facebook Google sẽ sớm "bêu tên" các nhà sản xuất Android chưa xử lý được các lỗ hổng bảo mật nguy hiểm

Google sẽ sớm "bêu tên" các nhà sản xuất Android chưa xử lý được các lỗ hổng bảo mật nguy hiểm Sự nguy hiểm của mã độc tống tiền: Có thể lọt qua các hệ thống bảo mật chặt chẽ nhất

Sự nguy hiểm của mã độc tống tiền: Có thể lọt qua các hệ thống bảo mật chặt chẽ nhất Song Hye Kyo tràn ngập ảnh, video nhạy cảm trên mạng xã hội, thủ phạm lại là Deepfake

Song Hye Kyo tràn ngập ảnh, video nhạy cảm trên mạng xã hội, thủ phạm lại là Deepfake Nhà báo dùng điện thoại quay clip xe múc đất đá rồi "gợi ý quà Tết"

Nhà báo dùng điện thoại quay clip xe múc đất đá rồi "gợi ý quà Tết"

Điều tra vụ 4 người trong một gia đình tử vong ở Hà Nội

Điều tra vụ 4 người trong một gia đình tử vong ở Hà Nội Vụ gần 47 tỷ đồng gửi Sacombank "bốc hơi": Tạm dừng phiên tòa

Vụ gần 47 tỷ đồng gửi Sacombank "bốc hơi": Tạm dừng phiên tòa

Tai nạn máy bay tại Hàn Quốc: Tìm thấy lông chim và máu trong động cơ máy bay

Tai nạn máy bay tại Hàn Quốc: Tìm thấy lông chim và máu trong động cơ máy bay Lê Tuấn Khang chia sẻ 8 chữ giữa tâm điểm tranh luận

Lê Tuấn Khang chia sẻ 8 chữ giữa tâm điểm tranh luận Cành đào huyền có giá "ngã ngửa", chính chủ đăng ảnh lập tức có người trả gấp 10 lần giá mua!

Cành đào huyền có giá "ngã ngửa", chính chủ đăng ảnh lập tức có người trả gấp 10 lần giá mua! Sốc: Triệu Vy là chủ mưu đứng sau đường dây buôn người sang Thái Lan - Myanmar?

Sốc: Triệu Vy là chủ mưu đứng sau đường dây buôn người sang Thái Lan - Myanmar? Soi ảnh cận nhan sắc của mẹ Phương Nhi, hóa ra Á hậu được thừa hưởng visual "đỉnh nóc" từ đây!

Soi ảnh cận nhan sắc của mẹ Phương Nhi, hóa ra Á hậu được thừa hưởng visual "đỉnh nóc" từ đây! Hé lộ phần quà cô dâu hào môn Phương Nhi tặng khách mời trong lễ ăn hỏi

Hé lộ phần quà cô dâu hào môn Phương Nhi tặng khách mời trong lễ ăn hỏi Con gái riêng chồng cũ Vũ Thu Phương nói về việc bị bạo hành: "Không lý do gì tôi phải dựng chuyện hạ bệ ai"

Con gái riêng chồng cũ Vũ Thu Phương nói về việc bị bạo hành: "Không lý do gì tôi phải dựng chuyện hạ bệ ai" Người đàn ông chém gục vợ cũ giữa đường rồi tự sát ở Cà Mau

Người đàn ông chém gục vợ cũ giữa đường rồi tự sát ở Cà Mau Á hậu Phương Nhi phản ứng thế nào sau 1 ngày tổ chức đám hỏi với thiếu gia Vingroup?

Á hậu Phương Nhi phản ứng thế nào sau 1 ngày tổ chức đám hỏi với thiếu gia Vingroup? Thiếu gia Vingroup - Chồng Á hậu Phương Nhi: Tổng tài 2K hiếm hoi lộ mặt, zoom cận góc nghiêng ngày đi hỏi vợ khiến nhiều người trầm trồ

Thiếu gia Vingroup - Chồng Á hậu Phương Nhi: Tổng tài 2K hiếm hoi lộ mặt, zoom cận góc nghiêng ngày đi hỏi vợ khiến nhiều người trầm trồ Chuyện gì đã xảy ra với Á hậu Phương Nhi và Hoa hậu Lương Thùy Linh?

Chuyện gì đã xảy ra với Á hậu Phương Nhi và Hoa hậu Lương Thùy Linh? Vụ gần 1.600 con lợn bị thiêu sống: "Tôi mất bình tĩnh quên cúp điện"

Vụ gần 1.600 con lợn bị thiêu sống: "Tôi mất bình tĩnh quên cúp điện"