Những người bị hủy hoại vì deepfake

Helen Mort sững sờ khi một người bạn nói loạt ảnh nuy của cô đang bị phát tán trên một trang web nhạy cảm.

Cô hoang mang bởi chưa bao giờ trong đời cô từng chụp hay chia sẻ những bức ảnh nhạy cảm. Hẳn phải có sự nhầm lẫn nào đó. Cuối cùng, sau khi thu hết can đảm để mở đường link, cô bỗng cảm thấy sợ hãi và nhục nhã.

Ngày càng nhiều phụ nữ trở thành nạn nhân của deepfake. Ảnh: MIT Technology Rreview.

Mort, nhà thơ kiêm phát thanh viên ở Sheffield (Anh), sốc bởi khuôn mặt trong ảnh đúng là cô. Ai đó cố tình lấy những tấm hình chụp từ năm 2017 đến 2019 mà cô đăng trên Facebook, như ảnh đi nghỉ mát, ảnh mang thai và thậm chí ảnh thời niên thiếu. Sau đó, người này ghép khuôn mặt cô thành ảnh nhạy cảm và bạo lực. Một số tấm được cắt ghép vụng về, nhưng một số chân thực đến rùng mình.

Khi tìm hiểu điều gì đang diễn ra với mình, Mort học được một thuật ngữ mới: deepfake, dùng để chỉ những nội dung như ảnh, video, văn bản, âm thanh được tạo ra, chỉnh sửa, cắt ghép… bằng các công cụ AI.

“Bạn cảm thấy bất lực. Bị trừng phạt vì là một phụ nữ có tiếng nói nhất định trước công chúng. Những bức ảnh như muốn nói: Nhìn đi, chúng tôi luôn có thể làm điều đó với cô”, Mort chia sẻ.

Trong sự giận dữ, cô muốn truy tìm kẻ tấn công. Cô gọi cảnh sát, nhưng họ nói không thể làm được gì. Cô định không sử dụng Internet nữa, nhưng không thể vì còn liên quan tới công việc của mình.

Mort hoàn toàn không đoán được ai đã làm điều đó. Và rồi cô sợ hãi khi nghe nói đó là người mà cô thân thiết. Cô bắt đầu nghi ngờ mọi người, đau đớn hơn là cô nghi cả chồng cũ. Sau khi chia tay, hai người vẫn là bạn tốt, nhưng kẻ tấn công đã sử dụng tên chồng cũ của cô làm biệt danh. “Dù đó không phải là anh ấy, điều đáng buồn là tôi bắt đầu hoài nghi toàn bộ các mối quan hệ của mình”, cô nói.

Helen Mort. Ảnh: MIT Technology Rreview.

Dù được cảnh báo nhiều về nguy cơ tác động đến chính trị, phần lớn deepfake hiện được sử dụng để nhắm vào phụ nữ. Công ty nghiên cứu Sensity AI đã theo dõi các video deepfake trên mạng từ tháng 12/2018 nhận thấy hơn 90% trong số đó có nội nhạy cảm.

“Đây là một dạng bạo lực nhằm vào phụ nữ”, Adam Dodge, sáng lập EndTAB, tổ chức phi lợi nhuận về giáo dục, nhận định. “Deepfake là công cụ hoàn hảo cho ai đó đang tìm cách sử dụng quyền lực và kiểm soát nạn nhân”.

Một số nạn nhân thậm chí phải đổi tên, xóa tất cả tài khoản của họ trên Internet. Họ vẫn luôn lo sợ rằng bất cứ lúc nào, những hình ảnh đó có thể xuất hiện trở lại và một lần nữa hủy hoại cuộc sống của họ.

Từ tháng 12/2017, Samantha Cole, phóng viên của Motherboard , phát hiện một người dùng Reddit với biệt danh “deepfakes” sử dụng công nghệ do giới nghiên cứu AI phát triển để hoán đổi, ghép khuôn mặt của những người nổi tiếng nữ vào video nhạy cảm. Cole cố gắng cảnh báo độc giả: Rồi những phụ nữ khác sẽ là nạn nhân tiếp theo.

Lời cảnh báo cũng thu hút sự chú ý nhất định, nhưng chủ yếu là vì sự mới mẻ của công nghệ. Còn đa số vẫn nghĩ đó là câu chuyện diễn ra ở đâu đó xa vời chứ không xảy ra với mình.

Deepfake hiện không còn thô sơ như bốn năm trước. Các công cụ AI hoàn toàn có thể cho ra đời video giả mạo trông chân thực, mắt thường khó phân biệt được trừ khi được cảnh báo trước. Thậm chí, đã xuất hiện công cụ biến ảnh chụp thành video sống động, hay một bot tự động trên Telegram có khả năng “lột” quần áo khỏi ảnh phụ nữ. Từ đó, việc tạo ra ảnh nuy của bất cứ phụ nữ nào trở nên dễ dàng, miễn là có ảnh khuôn mặt của người đó.

Giorgio Patrini, Giám đốc điều hành Sensity AI, cho biết phạm vi lạm dụng đang ngày càng tăng, không chỉ nhắm vào người nổi tiếng mà cả người bình thường.

Nhiều người nghĩ deepfake ra đời chỉ để phô diễn công nghệ hoặc giải trí, phục vụ các mục đích vô hại như hoán đổi khuôn mặt. Họ có thể vô tư ghép mặt mình hoặc bất cứ ai vào trong một đoạn phim, thay cho diễn viên nổi tiếng. Tuy nhiên, mọi thứ thay đổi khi khuôn mặt bạn bị ghép vào video nhạy cảm.

Trong bối cảnh đại dịch, xu hướng này càng đáng lo ngại khi nhiều người phải ở nhà và có thời gian rảnh lên mạng. “Mọi người có nhiều thời gian hơn để tìm hiểu và học cách sử dụng một số công nghệ kiểu này. Như thể một đợt sóng lớn sắp ập đến”, Sophie Mortimer, quản lý đường dây trợ giúp Revenge Porn phi lợi nhuận ở Anh, cảnh báo.

Karolina Mania, một học giả pháp lý, cho biết gần như chưa có nước nào cấm nội dung nhạy cảm giả mạo ở cấp quốc gia. Ví dụ ở Mỹ, 46 bang cấm phát tán ảnh hoặc video nhạy cảm của các cá nhân mà chưa có sự đồng tình của họ. Tuy nhiên, mới chỉ có lệnh cấm của Virginia và California bao gồm cả các nội dung giả mạo. Ở Anh, lan truyền hình ảnh nhạy cảm bị cấm, nhưng luật pháp không áp dụng cho các nội dung bị làm giả.

Do đó, các nạn nhân của deepfake gần như không được hỗ trợ, trừ trong các tình huống đặc biệt. Chẳng hạn, nếu khuôn mặt nạn nhân được lấy từ ảnh bản quyền, kẻ phát tán có thể bị phạt theo luật sở hữu trí tuệ. Hoặc nếu đủ căn cứ, họ có thể kiện về hành vi quấy rối. Tuy nhiên, thu thập đủ bằng chứng như vậy thường rất khó.

Điều này đúng với Mort. Cô chỉ biết về những bức ảnh ghép khi chúng đã tồn tại trên mạng hơn một năm. Kẻ lạm dụng cũng không nêu danh tính của cô, nên khó có thể nói đó là hành vi quấy rối có chủ đích.

Việc chưa có luật về deepfake, theo Dodge, là do đây chưa hẳn là một công nghệ phổ biến và khoảng 80% người dùng Internet vẫn chưa biết deepfake là gì. Tuy vậy, tín hiệu tích cực là sau nhiều năm các nhà hoạt động đấu tranh để bảo vệ các nạn nhân của bạo lực tình dục dựa trên hình ảnh, cuối cùng deepfake cũng đang buộc các nhà lập pháp ở nhiều nước phải chú ý tới.

Deepfake thành trò giải trí 'gây sốt' tại Việt Nam

Các ứng dụng như Avatatify, Reface... sử dụng kỹ thuật deepfake để tạo video giả hành động của con người, đang được dùng nhiều ở Việt Nam.

Những video như Elon Musk nói chuyện bằng tiếng Việt, hay hình ảnh một người nào đó cất giọng hát như ca sỹ nước ngoài, nam nói giọng nữ... xuất hiện nhiều trên mạng xã hội gần đây. Đây là video giả dạng bằng cách ghép mặt, được tạo bởi các ứng dụng như Avatarify, Reface... trên smartphone.

Nhiều video được đánh giá là "chân thực không thua kém video gốc". "Phải xem đến lần thứ hai và thấy logo của ứng dụng, tôi mới nhận ra đây là video giả", Tuấn Anh (Hà Nội) bình luận về một video với hình ảnh Elon Musk nói "chúc mừng sinh nhật" bằng tiếng Việt.

Video deepfake giả Elon Musk trong cuộc họp trên Zoom, dẫn đến ý tưởng tạo ra Avatarify.

Tuần qua, các nội dung "giả" này xuất hiện nhiều. Song song đó, các ứng dụng như Avatarify, Reface cũng lọt top những "app" được tải nhiều nhất trên iOS và Android tại Việt Nam. Hai ứng dụng này nhận được hàng nghìn đánh giá 5* từ người dùng Việt, với những lời khen về khả năng ghép mặt chính xác, biến ảnh tĩnh thành video, hay tạo ra những nội dung hài hước, độc đáo mà trước đây các ứng dụng khác không làm được.

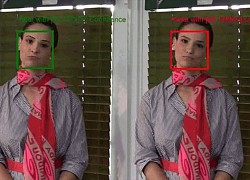

Nhìn chung, Avatarity và Reface có cơ chế hoạt động và cách sử dụng tương tự nhau. Với Avatarify, người dùng chọn một bức ảnh có khuôn mặt của mình, bạn bè hoặc người nổi tiếng nào đó, đưa vào app. Sau đó, chọn một video chứa biểu cảm mong muốn, thường là video về các ca sĩ đang hát, Avatarify sẽ "hòa trộn" biểu cảm này với khuôn mặt trong bức ảnh gốc, lồng ghép thêm âm thanh, tạo nên video giống đang biểu diễn. Nhờ khả năng "hòa trộn" theo thời gian thực, người dùng còn có thể lồng tiếng nói và biểu cảm của chính mình, vào khuôn mặt của người khác.

Ngược lại, Reface có khả năng ghép mặt mình vào video của người khác. Ứng dụng này thường được người Việt sử dụng để đưa mặt mình vào các video ca nhạc, phim hành động...

Chỉ mất chưa đến một phút là có thể tạo được một video deepfake từ ứng dụng trên điện thoại.

Điểm chung của các ứng dụng này, theo các chuyên gia, là sử dụng kỹ thuật deepfake để "trộn" khuôn mặt của người này với biểu cảm và giọng nói của người khác.

Sự nguy hiểm của công nghệ phía sau

Về mặt bảo mật, các ứng dụng trên đều khẳng định người dùng không cần cung cấp thông tin cá nhân. Ứng dụng cũng không tải ảnh của người dùng lên máy chủ để lưu trữ hoặc truy cập. Nền tảng kỹ thuật của Reface còn được ứng dụng trong ngành giải trí, hứa hẹn tạo nên cuộc cách mạng về làm phim.

Tuy nhiên, kỹ thuật phía sau ứng dụng này là deepfake - từng được cảnh báo có thể gây ra những hậu quả nghiệm trọng, như mạo danh, ghép mặt người vào video nhạy cảm.

Ở phiên bản miễn phí của Reface, người dùng chỉ có thể ghép hình trong các video, ảnh động, có sẵn trong thư viện ứng dụng. Với bản trả phí (giá 579 nghìn đồng/năm), người dùng có thể thêm bất kỳ video nào vào thư viện để ghép mặt. Dù là ứng dụng được sử dụng với mục đích giải trí, các chuyên gia bảo mật lo ngại công nghệ này có thể bị lợi dụng cho mục đích xấu.

Ứng dụng Avatarify cho phép "trộn" biểu cảm của người này vào khuôn mặt của người khác.

Hồi đầu năm 2020, nhà sáng lập Ali Aliev của Avatarify đã sử dụng công nghệ mã nguồn mở, sau đó "tinh chỉnh trong vài giờ" để tạo nên ứng dụng này. Ali cho biết anh đã thử công cụ này với hai người bạn của mình - vốn là các nhà nghiên cứu về AI và chính họ cũng "bối rối" khi thấy mình đang họp cùng "Elon Musk". Từ kết quả này, nhóm của Ali đã tiến tới phát triển các ứng dụng deepfake, có khả năng tích hợp vào cuộc họp trong Zoom và Skype.

Mã nguồn của Avatarify được công khai trên Github. Các chuyên gia bảo mật cho biết họ không lo ngại về việc các ứng dụng này lấy dữ liệu hình ảnh của người dùng nữa, mà lo là deepfake đang được sử dụng quá dễ dàng.

Trước đây, việc tạo các video deepfake yêu cầu phần cứng máy tính mạnh mẽ, hoặc chi phí hàng chục USD cho mỗi video, nhưng nay có thể thực hiện miễn phí trên điện thoại, chỉ với vài thao tác đơn giản. Nhiều chính trị gia, ngôi sao nổi tiếng từng trở thành nạn nhân của deepfake khi bị ghép mặt vào các video nhạy cảm.

Trong bối cảnh ngày càng nhiều ngân hàng, sàn giao dịch điện tử ứng dụng phương thức xác thực danh tính bằng eKYC (electronic Know Your Customer), sự phát triển của deepfake có thể trở thành mối đe dọa.

Một trong những bước quan trọng của eKYC là đối chiếu hình ảnh "sống" của người dùng với ảnh từ giấy tờ tùy thân. Các chuyên gia bảo mật cho biết, họ nhận thấy nhu cầu tạo hình ảnh deepfake đang ngày càng cao. Trên môi trường darkweb, giới tin tặc liên tục khoe những lần hình ảnh deepfake của chúng vượt qua được giải pháp eKYC.

Theo trang Gemini, các phần mềm phát hiện deepfake đang tụt hậu so với sự phát triển của công nghệ này. Độ chính xác của các công cụ này hiện chỉ ở mức 65,18%, tức là có đến 1/3 số hình là giả mà không thể phát hiện được. Trong khi đó, các giải pháp deepfake như Avatarify lại sử dụng AI và có mã nguồn mở, nên kết quả chúng tạo ra sẽ ngày càng "thật", kéo theo việc phát hiện ra deepfake khó khăn hơn.

Facebook là nguồn phát tán tin giả tồi tệ nhất  Trong số các nền tảng mạng xã hội lớn của thế giới, Facebook chính là nền tảng phát tán tin giả tồi tệ nhất. Đây chính là kết luận của nghiên cứu đăng trên tạp chí Nature: Human Behavior tháng 3/2020. Một nhóm nghiên cứu do chuyên gia Andrew Guess của Đại học Princeton dẫn đầu đã theo dõi lượng sử dụng Internet...

Trong số các nền tảng mạng xã hội lớn của thế giới, Facebook chính là nền tảng phát tán tin giả tồi tệ nhất. Đây chính là kết luận của nghiên cứu đăng trên tạp chí Nature: Human Behavior tháng 3/2020. Một nhóm nghiên cứu do chuyên gia Andrew Guess của Đại học Princeton dẫn đầu đã theo dõi lượng sử dụng Internet...

Clip xe khách xoay 180 độ trên đường ở Bình Dương, tông chết một phụ nữ00:23

Clip xe khách xoay 180 độ trên đường ở Bình Dương, tông chết một phụ nữ00:23 Màn khoá môi của Lê Dương Bảo Lâm và Lê Giang khiến MXH chấn động01:37

Màn khoá môi của Lê Dương Bảo Lâm và Lê Giang khiến MXH chấn động01:37 Shipper giao hàng cho người đã... mất: Người trong cuộc hé lộ sự thật02:16

Shipper giao hàng cho người đã... mất: Người trong cuộc hé lộ sự thật02:16 Công chúa Vpop U40 lên sóng sinh nhật TVB, dàn sao Hoa ngữ còn hát bằng tiếng Việt đầy bất ngờ05:21

Công chúa Vpop U40 lên sóng sinh nhật TVB, dàn sao Hoa ngữ còn hát bằng tiếng Việt đầy bất ngờ05:21 Tiết mục biểu diễn văn nghệ mừng 20/11 của học sinh lớp 1 khiến dân tình "ngả mũ": Quá nể các cô giáo rồi!03:18

Tiết mục biểu diễn văn nghệ mừng 20/11 của học sinh lớp 1 khiến dân tình "ngả mũ": Quá nể các cô giáo rồi!03:18 Xôn xao clip cô giáo mầm non cho cả lớp xếp hàng tát liên tiếp 1 bạn, lý do càng gây tranh cãi00:33

Xôn xao clip cô giáo mầm non cho cả lớp xếp hàng tát liên tiếp 1 bạn, lý do càng gây tranh cãi00:33 Độc đạo - Tập 36: Hồng 'đấu tay đôi' thắng Quân già?03:12

Độc đạo - Tập 36: Hồng 'đấu tay đôi' thắng Quân già?03:12 Hoa hậu Kỳ Duyên về nước: Visual khác hẳn đêm chung kết, bị "đánh úp" 1 điều ngay tại sân bay01:34

Hoa hậu Kỳ Duyên về nước: Visual khác hẳn đêm chung kết, bị "đánh úp" 1 điều ngay tại sân bay01:34 Thợ trang điểm bật khóc nức nở khi bị gia đình chú rể lục soát vali, yêu cầu cởi đồ để kiểm tra sau khi bị mất 20 triệu đồng trong đám cưới00:50

Thợ trang điểm bật khóc nức nở khi bị gia đình chú rể lục soát vali, yêu cầu cởi đồ để kiểm tra sau khi bị mất 20 triệu đồng trong đám cưới00:50 Vừa làm bài tập xong, bé gái bất ngờ lăn đùng ra giữa nhà gào khóc, hàng xóm cũng vội vàng kéo sang hỏi thăm00:54

Vừa làm bài tập xong, bé gái bất ngờ lăn đùng ra giữa nhà gào khóc, hàng xóm cũng vội vàng kéo sang hỏi thăm00:54 Hoa sữa về trong gió - Tập 54: Hiếu phát hiện vợ gặp lại tình cũ03:21

Hoa sữa về trong gió - Tập 54: Hiếu phát hiện vợ gặp lại tình cũ03:21Tin đang nóng

Tin mới nhất

Nâng cao và biến đổi hình ảnh của bạn bằng trình chỉnh sửa video trực tuyến CapCut

Cách đăng Facebook để có nhiều lượt thích và chia sẻ

Thêm nhiều bang của Mỹ cấm TikTok

Microsoft cấm khai thác tiền điện tử trên các dịch vụ đám mây để bảo vệ khách hàng

Facebook trấn áp hàng loạt công ty phần mềm gián điệp

Meta đối mặt cáo buộc vi phạm các quy tắc chống độc quyền với mức phạt 11,8 tỷ đô

Không cần thăm dò, Musk nên sớm từ chức CEO Twitter

Đại lý Việt nhập iPhone 14 kiểu 'bia kèm lạc'

Khai trương hệ thống vé điện tử và dịch vụ trải nghiệm thực tế ảo XR tại Quần thể Di tích Cố đô Huế

'Dở khóc dở cười' với tính năng trợ giúp người bị tai nạn ôtô của Apple

Xiaomi sa thải hàng nghìn nhân sự

Apple sẽ bắt đầu sản xuất MacBook tại Việt Nam vào giữa năm 2023

Có thể bạn quan tâm

Nicole Kidman bị chỉ trích nói dối về "meme ăn mừng ly hôn Tom Cruise"

Sao âu mỹ

21:32:02 22/11/2024

Xem ngay sân khấu đầu tiên của siêu hit APT.: Rosé và Bruno Mars "quẩy" cực vui nhưng 1 điểm gây hụt hẫng!

Nhạc quốc tế

21:20:33 22/11/2024

Thượng nghị sĩ Mỹ Lindsey Graham kêu gọi trừng phạt ICC sau lệnh bắt Thủ tướng Israel

Uncat

21:16:32 22/11/2024

Bức ảnh chụp lúc 5h sáng cho thấy 1 sự thật về ngôi sao hạng S của Vbiz

Nhạc việt

21:14:44 22/11/2024

Nhật Bản: Số ca mắc mới COVID-19 hằng tuần tăng lần đầu tiên trong 3 tháng

Thế giới

21:10:08 22/11/2024

Sao Việt 22/11: NSND Công Lý sắp trở lại màn ảnh nhỏ

Sao việt

20:49:03 22/11/2024

Nóng nhất MXH: Từ Hy Viên và chồng Hàn Quốc đã ly hôn?

Sao châu á

20:45:54 22/11/2024

Du khách Tây gãy chân nhưng vẫn quyết chinh phục Hà Giang: Cách làm thông minh khiến dân mạng phải bật cười

Netizen

20:11:23 22/11/2024

Chủ tịch Hội nông dân xã mất tích bí ẩn

Tin nổi bật

20:10:59 22/11/2024

Dẫn lưu não thất - ổ bụng điều trị não úng thủy cho bệnh nhi sinh non

Sức khỏe

20:10:31 22/11/2024

Trải nghiệm một tuần chỉ tiêu Bitcoin

Trải nghiệm một tuần chỉ tiêu Bitcoin Tranh cãi đèn năng lượng mặt trời tiết kiệm điện

Tranh cãi đèn năng lượng mặt trời tiết kiệm điện

Nóng: Cảnh báo công cụ Deepfake sẽ xoá hết quần áo chỉ trong vòng vài nốt nhạc, chị em hay post ảnh khoe thân nên thận trọng!

Nóng: Cảnh báo công cụ Deepfake sẽ xoá hết quần áo chỉ trong vòng vài nốt nhạc, chị em hay post ảnh khoe thân nên thận trọng! Ngăn chặn video xấu độc làm hại trẻ em: Cần sự chung tay của cả cộng đồng

Ngăn chặn video xấu độc làm hại trẻ em: Cần sự chung tay của cả cộng đồng Nỗi sợ deepfake nguy hiểm hơn chính deepfake

Nỗi sợ deepfake nguy hiểm hơn chính deepfake Khóa 34.700 thuê bao phát tán cuộc gọi rác, chặn 9 triệu cuộc gọi giả mạo

Khóa 34.700 thuê bao phát tán cuộc gọi rác, chặn 9 triệu cuộc gọi giả mạo Song Hye Kyo tràn ngập ảnh, video nhạy cảm trên mạng xã hội, thủ phạm lại là Deepfake

Song Hye Kyo tràn ngập ảnh, video nhạy cảm trên mạng xã hội, thủ phạm lại là Deepfake Microsoft ra công cụ phát hiện ảnh deepfake

Microsoft ra công cụ phát hiện ảnh deepfake Người phụ nữ gửi tiết kiệm 168 tỷ đồng, nửa tiếng sau tài khoản còn 0 đồng, tòa án tuyên bố: Ngân hàng không cần bồi thường

Người phụ nữ gửi tiết kiệm 168 tỷ đồng, nửa tiếng sau tài khoản còn 0 đồng, tòa án tuyên bố: Ngân hàng không cần bồi thường Vụ Trường THPT Tô Hiến Thành tuyển sinh "chui": Tình tiết mới nhất

Vụ Trường THPT Tô Hiến Thành tuyển sinh "chui": Tình tiết mới nhất Kiểm tra cặp của con sau khi đi học về, phụ huynh TP.HCM bàng hoàng phát hiện ra thứ bên trong: Sao lại có thể như thế?

Kiểm tra cặp của con sau khi đi học về, phụ huynh TP.HCM bàng hoàng phát hiện ra thứ bên trong: Sao lại có thể như thế? Như Quỳnh: "Tôi hối hận vì đã làm điều đó với Hiền Thục"

Như Quỳnh: "Tôi hối hận vì đã làm điều đó với Hiền Thục" Khả năng ca hát của Minh Hằng so với Tóc Tiên ra sao?

Khả năng ca hát của Minh Hằng so với Tóc Tiên ra sao? MAMA ngày 1: "Bà cả Penthouse" U50 đọ dáng cực gắt với Jang Won Young, Park Bo Gum - Byeon Woo Seok visual 10/10

MAMA ngày 1: "Bà cả Penthouse" U50 đọ dáng cực gắt với Jang Won Young, Park Bo Gum - Byeon Woo Seok visual 10/10 Sao Việt 22/11: Hoa hậu Ý Nhi về nước, Trương Ngọc Ánh hội ngộ chồng cũ

Sao Việt 22/11: Hoa hậu Ý Nhi về nước, Trương Ngọc Ánh hội ngộ chồng cũ Ca sĩ Bích Tuyền: Đàm Vĩnh Hưng đòi Gerard Williams 15 triệu USD trước khi khởi kiện

Ca sĩ Bích Tuyền: Đàm Vĩnh Hưng đòi Gerard Williams 15 triệu USD trước khi khởi kiện Hiện trường hơn 200 bộ hài cốt vừa được phát hiện giữa Hà Nội

Hiện trường hơn 200 bộ hài cốt vừa được phát hiện giữa Hà Nội Sự hết thời của 1 siêu sao: 2000 ngày không ai mời đóng phim, nhan sắc lẫn diễn xuất đều tụt dốc thảm hại

Sự hết thời của 1 siêu sao: 2000 ngày không ai mời đóng phim, nhan sắc lẫn diễn xuất đều tụt dốc thảm hại Hà Nội: Phát hiện gần 150 bộ hài cốt tại phố Tây Sơn

Hà Nội: Phát hiện gần 150 bộ hài cốt tại phố Tây Sơn Sau video gây xôn xao, Hoài Lâm từ bỏ nghệ danh NS Hoài Linh đặt cho?

Sau video gây xôn xao, Hoài Lâm từ bỏ nghệ danh NS Hoài Linh đặt cho? Báo quốc tế ngợi ca vẻ đẹp hùng vĩ của Cao Bằng

Báo quốc tế ngợi ca vẻ đẹp hùng vĩ của Cao Bằng 1 Hoa hậu và chồng ca sĩ Vbiz xác nhận đã âm thầm đón con đầu lòng

1 Hoa hậu và chồng ca sĩ Vbiz xác nhận đã âm thầm đón con đầu lòng Biết đứa thứ 5 là con gái, bố tôi bỏ mặc vợ đẻ trong trạm xá đến tận 26 năm mới quay lại

Biết đứa thứ 5 là con gái, bố tôi bỏ mặc vợ đẻ trong trạm xá đến tận 26 năm mới quay lại Cảnh tượng livestream hỗn loạn gây bức xúc của TikToker, YouTuber tại lễ tang con gái nuôi NS Kim Tiểu Long

Cảnh tượng livestream hỗn loạn gây bức xúc của TikToker, YouTuber tại lễ tang con gái nuôi NS Kim Tiểu Long