AI sắp được định tội con người

Một dự luật mới có thể được thông qua tại bang California, Mỹ. Các phạm nhân sẽ được đánh giá về khả năng phạm tội dựa vào một thuật toán còn đang tranh cãi.

Bang California đang nỗ lực xóa bỏ phương pháp bảo lãnh truyền thống bằng tiền mặt. Họ muốn áp dụng một hệ thống bắt giữ người dựa trên các khuyến nghị từ thuật toán mang tên “dự đoán tội phạm”. Tuy vậy, nhiều chuyên gia lo ngại vấn đề phân biệt đối xử sẽ nảy sinh.

Theo Dự luật 25, vào tháng 11 này, các thẩm phán sẽ được yêu cầu sử dụng một thuật toán, được gọi là “công cụ đánh giá rủi ro”.

Phần mềm này dự đoán liệu một bị cáo có thể bỏ trốn nếu được phóng thích hay không. Nếu điểm “rủi ro” đủ cao, bị cáo sẽ bị bỏ tù. Họ không thể nộp tiền tại ngoại vì Dự luật này cũng loại bỏ tiến trình này.

Các chuyên gia cho biết, các thẩm phán có thể sửa đổi đề xuất của thuật toán dựa trên nhận định của mình. Tuy vậy, họ sẽ nghiêng về có xu hướng thay đổi đề xuất thả tù nhân, chứ ít khi thả tù nhân dù có khuyến nghị bỏ tù, John Raphling, nhà nghiên cứu cấp cao về quyền con người nhận định.

Dự luật đã giành được nhiều tán dương từ các nhà cải cách, theo đó đây là giải pháp khoa học để hạn chế sự phân biệt chủng tộc. Đồng thời, việc xóa bỏ cơ chế bảo lãnh tại ngoại sẽ giảm thiểu việc những người giàu có dùng tiền mua lấy tự do.

Tháng 11 này, các bị cáo sẽ được đánh giá bởi các thuật toán để quyết định việc tại ngoại hay không

Tuy vậy, thuật toán dự đoán này bị lo ngại sẽ tạo ra những hệ thống phân biệt chủng tộc mới.

1/3 quận ở Mỹ từ lâu đã âm thầm sử dụng thuật toán tương tự để dự đoán tội phạm trước khi bắt đầu phiên sơ thẩm. Phần lớn các thuật toán được phát triển bởi các doanh nghiệp tư nhân.

Hannah Sassaman, giám đốc chính sách của Dự án Liên minh Phong trào tiết lộ rằng: “Thường sẽ không có bất kỳ thông báo hoặc thông cáo báo chí nào. Những công cụ này được sử dụng trong bóng tối”.

Bang California từng nỗ lực để cấm bảo lãnh tiền mặt và ủng hộ sử dụng thuật toán trong trong Dự luật Thượng viện 10 (SB10) vào năm 2016 và nhanh chóng trở thành luật chính thức vào năm 2018.

Tuy nhiên bên ủng hộ phương pháp bảo lãnh truyền thống phản đối dự luật này và chỉ dừng lại khi Đề xuất 25 ra đời vào năm nay.

Ít nhất 49/58 quận của bang California đã trang bị các thuật toán đánh giá rủi ro nhưng trước đây chúng chỉ được sử dụng trong số ít trường hợp.

Pilar Weiss, giám đốc điều hành của Community Justice Exchange nói rằng: “Một số nơi hoàn toàn không ủng hộ các thuật toán này nhưng điều đó sẽ thay đổi theo dự luật SB10″.

Video đang HOT

VẪN CÒN NHIỀU TRANH CÃI

SB10 được cho là sẽ không áp đặt tiêu chuẩn lên các thuật toán. Mỗi quận có thể xử lý dữ liệu khác nhau như cách mà họ vẫn đang làm.

Điển hình như việc hai quận đã sử dụng công cụ Đánh giá An toàn Công cộng (PSA), để xác định xem có nên giam giữ một ai đó hay không. Trong khi, quận Los Angeles lại sử dụng phiên bản sửa đổi của công cụ Hồ sơ quản lý phạm nhân cải tạo cho các hình phạt thay thế (COMPAS).

Các thuật toán tuy khác nhau về hình thức nhưng bản chất của chúng lại giống nhau: Đánh giá ai đó dựa trên tiền sử phạm tội trước đây của họ. Đây là các “sai sót không thể sửa chữa” của các thuật toán, theo Bernard Harcourt, giáo sư luật và khoa học chính trị tại Trường Luật Columbia.

Bởi vì các thuật toán đánh giá dựa trên số lần bị cảnh sát bắt giữ nhưng lại không quan tâm về hình thức bắt giữ và liệu một ai đó có bị bắt oan hay không.

Và cảnh sát Mỹ thường bị chỉ trích là nhắm vào người nghèo, người da đen, trẻ em da màu, người chuyển giới, người nhập cư và người bán dâm.

Cảnh sát Mỹ thường bị chỉ trích là nhắm vào người da đen, một sai sót tiềm năng của thuật toán dự đoán tội phạm.

Các thuật toán còn được quảng cáo là một phương pháp hiệu quả và tiết kiệm chi phí để ngăn chặn tội phạm. Tuy nhiên theo giáo sư Harcourt “các thuật toán không dự đoán được hành vi, chúng chỉ đang dự đoán chính sách”.

Cũng như các hệ thống thuật toán dự đoán khác, thuật toán đánh giá rủi ro “nhúng” sự phân biệt đối xử đã tồn tại từ lâu.

Ví dụ, khi một thuật toán đánh giá trình độ học vấn hoặc công việc của một ai đó sẽ dựa trên các yếu tố như: chủng tộc, giai cấp và giới tính để quyết định về trình độ học vấn và thu nhập của người đó.

Các thẩm phán sau đó dựa vào đó để ấn định mức bảo lãnh cao hơn và thường gây áp lực buộc các bị cáo phải nhận tội. Những bị cáo bị bỏ tù vì không đủ khả năng chi trả tiền bảo lãnh đơn giản sẽ “nhận tội nhanh hơn và ít gây gổ hơn,” Raphling, một cựu luật sư ở California, cho biết.

Một nhóm biểu tình chống dự luật SB10 năm 2018.

Các thuật toán cũng thống kê các tiền án trước đây. Tỷ lệ vụ án hình sự được đưa ra xét xử tại California năm 2018 là 0.95%. Nếu SB10 trở thành luật, tỷ lệ này sẽ tăng lên.

“Hệ thống pháp luật sẽ tiếp tục bất công và lũng đoạn”, luật sư Raphling nói thêm.

Kể từ những năm 1920, khi các dự đoán tội phạm lần đầu tiên được sử dụng, hồ sơ tiền án đã được sử dụng như là một dự đoán tốt nhất về hành vi trong tương lai.

Ngay cả khi các dự đoán này chính xác, cuối cùng thuật toán không quyết định bỏ tù ai đó mà chính là hệ thống đạo đức xã hội và chính trị.

Giáo sư Harcourt cuối cùng kết luận rằng: “Chúng ta nên đầu tư vào ai đó được dự đoán sẽ phạm tội lần hai thay vì trừng phạt họ”.

Giao diện não - máy tính khiến con người không còn quyền riêng tư

Tín hiệu não là cấp độ cao nhất của quyền riêng tư. Khi chip "đọc" được mong muốn của não, đồng nghĩa, người dùng đã mất quyền riêng tư cuối cùng.

Tại hội nghị "An ninh mạng 2020" diễn ra tại Trung Quốc, Zhou Hongyi, Chủ tịch công ty bảo mật Internet Qihoo đã công khai lên án công nghệ cấy chip não do tỷ phú Elon Musk phát triển. "Những người như Elon Musk, nửa chính nửa tà. Bước chân vào thế giới giao diện máy tính não có thể giúp đỡ những người bị khuyết tật. Nhưng một ngày nào đó, khi Internet được kết nối với não của tất cả mọi người thì đó là là viễn cảnh khủng khiếp. Nó không đơn giản như cú liếc trộm vào màn hình điện thoại mà còn là những vấn đề về đạo đức, luật pháp", tỷ phú Zhou nói.

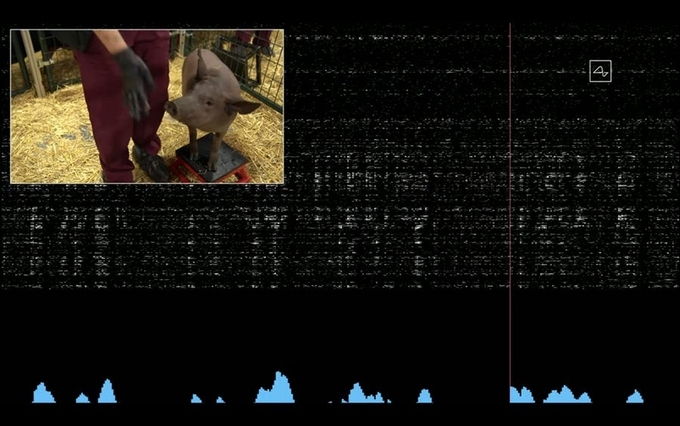

Sóng não của lợn được hệ thống của Neuralink ghi lại. Ảnh: Neuralink.

Quyền riêng tư cuối cùng của người dùng

Năm 2017, trong một bài báo đăng trên tạp chí Nature, các học giả đã đưa ra bốn đề xuất đạo đức cho sự phát triển của công nghệ thần kinh. Trong đó, quyền riêng tư được đặt lên hàng đầu. Mặc dù vẫn còn khá lâu mới đến kỷ nguyên "cộng sinh" giữa não người và máy tính, những nguy cơ về quyền riêng tư đã hiện hữu ngay thời điểm bộ não con người có thể được mã hóa.

Trong kỷ nguyên di động, người dùng phải đánh đổi ít nhiều quyền riêng tư khi các ứng dụng yêu cầu truy cập vào micro, camera, định vị, lịch sử trình duyệt web... để lấy sự thuận tiện trong cuộc sống. Việc "nghe trộm" có thể thấy ngay từ quảng cáo hoặc nội dung được đề xuất trước khi người dùng có ý định tìm kiếm. Đó là hai mặt của công nghệ, tương tự việc cấy ghép chip vào não người cũng có những mặt tối nhất định mà người dùng phải được nhìn nhận một cách đầy đủ. Nếu người dùng giao bộ não của mình cho một cỗ máy mà không biết chắc hệ thống máy chủ có an toàn không, đó sẽ là viễn cảnh tồi tệ mà người dùng phải suy nghĩ nghiêm túc.

Ví dụ, khi chip được cấy vào não người, một tổ chức có thể đọc mọi suy nghĩ lướt qua của người dùng. Sau đó họ lên danh sách "những người có nguy cơ thành tội phạm" và coi đó là bằng chứng trước toà. Điều này nghe có vẻ ngớ ngẩn, nhưng chẳng có gì đảm bảo nó sẽ không xảy ra.

Để dễ hình dung, bạn có thể xem lại bộ phim Tin tặc: Thế giới ngầm năm 2016. Phim lấy bối cảnh thế giới loài người mất hoàn toàn quyền riêng tư do não bộ được trực quan hoá mọi thông tin. Để giảm tỷ lệ tội phạm, chính phủ đã cấy chip vào những đứa trẻ khi chúng vừa chào đời. Mọi thứ công dân thấy đều được lưu trữ trên đám mây và chính phủ có thể giám sát tất cả. Tuy nhiên, những kẻ xấu có thể truy cập vào hệ thống và làm chuyện xấu.

Viễn cảnh trong phim đã được hiện thực hoá bằng cỗ máy P300. Đây là thiết bị tín hiệu não đặc biệt, được cấy ghép sau đầu, có thể nhắc nhở não điều gì cần chú ý. Một ứng dụng phổ biến hơn được sử dụng từ thế kỷ trước là máy phát hiện nói dối Polygraph.

Những ví dụ này cho thấy cảnh báo về quyền riêng tư cuối cùng của con người có thể chấm dứt trong kỷ nguyên chip não là hoàn toàn có căn cứ. Công nghệ giao diện não - máy tính có thể đặt dấu chấm hết cho những bí mật thầm kín nhất của con người.

Ranh giới giữa người và AI

Vấn đề thứ hai thế giới phải đối mặt khi hợp nhất não người với máy tính là bằng cách nào phân biệt được một hành vi do não hay chip quyết định. Công nghệ xe tự lái là một ví dụ. Nếu chiếc xe liên quan đến một vụ tai nạn, ai sẽ là người chịu trách nhiệm? Chủ xe hay nhà sản xuất cung cấp dịch vụ xe tự lái?

Trong phân tâm học, ba miền của tâm thức gồm: "cái tôi" (ego) còn gọi là bản ngã, "nó" (id) và "cái siêu tôi" (superego). Do nhiều yếu tố tác động bên ngoài, bản ngã thường bị kiềm chế bởi sự tự ý thức hay những ràng buộc xã hội. Tuy nhiên, máy móc không biệt được ba miền của tâm thức như não bộ. Nó có thể diễn giải những ham muốn vụt qua và hành động bốc đồng dẫn đến những tác động tai hại. Lúc này, ai sẽ chịu trách nhiệm và trách nhiệm là gì? Rõ ràng luật pháp đang đi sau công nghệ, trong khi những tác động của công nghệ lại quá lớn.

Và khi có gì đó không may xảy ra, các bên có thể viện lý do "thiết bị hỏng" làm "con dê tế thần". Vì suy cho cùng, miễn nó là một thiết bị, nó có quyền được hỏng.

Những băn khoăn này lại dẫn đến một câu hỏi lớn hơn: Nếu bộ não có thể để máy móc "làm việc thay mình", còn gì để chứng minh đó là một con người?

Khi giới thiệu hệ thống giao diện thần kinh máy tính - não, Musk nói: "Con người sẽ tiến đến một nền văn minh mới, nơi con người và AI sẽ sống vĩnh cửu". Tuy nhiên, tỷ phú gốc Nam Phi đã quên rằng văn minh của loài người phải dựa trên loài người chứ không phải máy móc.

Nhà triết học Plutarch đã đặt ra một câu hỏi: "Nếu tất cả mảnh gỗ trên con thuyền Theseus của vua Athens bị thay thế dần cho đến khi tất cả gỗ không còn là gỗ ban đầu, đây có còn là con thuyền Theseus không?".

Câu hỏi này được các nhà Nhân học hiện đại tiếp tục phát triển thành một vấn đề thời sự hơn: "Nếu mọi bộ phận trên cơ thể một người được thay thế, liệu người đó có còn là chính họ không?".

Thực tế, các thí nghiệm trước đây đã cho thấy, khi các điện cực được cấy vào não người để kích thích sâu, một số người cảm thấy tính cách của họ thay đổi. Năm 2016, một bệnh nhân đã sử dụng máy kích thích não để điều trị chứng trầm cảm kéo dài bảy năm. Người này mô tả lại: "Não tôi đúng là hoạt động lại, nhưng cách tôi tương tác với mọi người có gì đó khá lạ. Tôi không chắc mình là ai".

Công nghệ thần kinh có thể phá vỡ ý thức về "cái tôi" và sự chủ động của con người. Nó sẽ đe doạ đến bản chất của con người. Nếu giao diện máy tính - não thực sự như Musk nói, khi đó, liệu con người có còn là con người không?

Tương lai của công nghệ chip não

Công nghệ có thể bắt đầu từ những ý tưởng điên rồ nhưng không thể tách rời thực tế. Điều mà Musk và nhiều nhà khoa học đang hướng đến là giao diện não - máy tính có thể sửa đổi những hạn chế của con người. Musk nói về viễn cảnh con người có thể hợp nhất với AI, nhưng trước đó vài năm, chính ông cũng tuyên bố rằng AI quá nguy hiểm, nó sẽ đưa loài người đến diệt vong.

Thái độ tích cực của dư luận với giao diện não - máy tính là do những tác động tích cực của nó. Hầu hết các công ty, tổ chức nghiên cứu công nghệ thần kinh đều tập trung vào lĩnh vực giáo dục, y tế, tiêu dùng và văn hóa. Trong đó, giáo dục và chăm sóc y tế được trú trọng hơn cả. Giao diện não - máy tính thực sự tạo ra những bước đột phá trong lĩnh vực y tế, chẳng hạn cấy ghép chip điện tử vào bộ khung xương nhân tạo để giúp bệnh nhân đi lại.

Tuy nhiên, khi công nghệ này còn trong giai đoạn khởi thuỷ, các quy định về đạo đức, luật pháp phải được hình thành để tránh những tác động không mong muốn.

Gao Xiaorong, Giáo sư khoa Kỹ thuật Y sinh của Đại học Thanh Hoa và là người đứng đầu Phòng thí nghiệm "Giao diện não - máy tính" của Trung Quốc, đã phát biểu tại "Hội nghị Robot thế giới năm 2019" rằng: "Khi xem xét công nghệ giao diện não - máy tính từ góc nhìn đạo đức, ta nên lạc quan vì phần 'người' sẽ luôn chiến phần lớn. Tuy nhiên, phải đặc biệt thận trọng với các vấn đề nội bộ, như sao chép hoặc ghi mệnh lệnh vào bộ não".

Da điện tử phản ứng với cơn đau như con người  Các nhà nghiên cứu Đại học RMIT (Úc) đã phát triển một loại da nhân tạo có thể phản ứng với cơn đau giống như con người, cung cấp phản hồi "gần như tức thì" nếu áp suất và nhiệt độ chạm mức khiến ai đó kêu lên. Da nhân tạo được phát triển giống da người Theo Engadget, nguyên mẫu da điện...

Các nhà nghiên cứu Đại học RMIT (Úc) đã phát triển một loại da nhân tạo có thể phản ứng với cơn đau giống như con người, cung cấp phản hồi "gần như tức thì" nếu áp suất và nhiệt độ chạm mức khiến ai đó kêu lên. Da nhân tạo được phát triển giống da người Theo Engadget, nguyên mẫu da điện...

Video: Vợ Vũ Cát Tường nhảy tặng chú rể quá xuất sắc, Đông Nhi - Diệu Nhi rưng rưng xúc động02:05

Video: Vợ Vũ Cát Tường nhảy tặng chú rể quá xuất sắc, Đông Nhi - Diệu Nhi rưng rưng xúc động02:05 Đoạn video 38 giây từ camera an ninh siêu thị trở thành nỗi ám ảnh cả đời của một người mẹ: Không ai đoán được những gì diễn ra sau đó00:39

Đoạn video 38 giây từ camera an ninh siêu thị trở thành nỗi ám ảnh cả đời của một người mẹ: Không ai đoán được những gì diễn ra sau đó00:39 Hy hữu nam thanh niên nghi say thuốc lào ngã ra đường bị ô tô tông trúng00:53

Hy hữu nam thanh niên nghi say thuốc lào ngã ra đường bị ô tô tông trúng00:53 4 phút viral khắp cõi mạng: Em trai "bóc phốt" Vũ Cát Tường ngay giữa lễ đường, tiết lộ tính cách thật của chị dâu Bí Đỏ04:14

4 phút viral khắp cõi mạng: Em trai "bóc phốt" Vũ Cát Tường ngay giữa lễ đường, tiết lộ tính cách thật của chị dâu Bí Đỏ04:14 Gần 1 triệu người xem Gil Lê xoa lưng Xoài Non: Thì ra đây là lý do khiến hot girl 2K2 mê tít!01:15

Gần 1 triệu người xem Gil Lê xoa lưng Xoài Non: Thì ra đây là lý do khiến hot girl 2K2 mê tít!01:15 Lạng lách đánh võng trên đường, nhóm thanh niên gặp nạn, 1 người tử vong00:19

Lạng lách đánh võng trên đường, nhóm thanh niên gặp nạn, 1 người tử vong00:19Tin đang nóng

Tin mới nhất

Nâng cao và biến đổi hình ảnh của bạn bằng trình chỉnh sửa video trực tuyến CapCut

Cách đăng Facebook để có nhiều lượt thích và chia sẻ

Thêm nhiều bang của Mỹ cấm TikTok

Microsoft cấm khai thác tiền điện tử trên các dịch vụ đám mây để bảo vệ khách hàng

Facebook trấn áp hàng loạt công ty phần mềm gián điệp

Meta đối mặt cáo buộc vi phạm các quy tắc chống độc quyền với mức phạt 11,8 tỷ đô

Không cần thăm dò, Musk nên sớm từ chức CEO Twitter

Đại lý Việt nhập iPhone 14 kiểu 'bia kèm lạc'

Khai trương hệ thống vé điện tử và dịch vụ trải nghiệm thực tế ảo XR tại Quần thể Di tích Cố đô Huế

'Dở khóc dở cười' với tính năng trợ giúp người bị tai nạn ôtô của Apple

Xiaomi sa thải hàng nghìn nhân sự

Apple sẽ bắt đầu sản xuất MacBook tại Việt Nam vào giữa năm 2023

Có thể bạn quan tâm

Cảnh sát đột kích "sào huyệt" tổ chức quốc tế lừa đảo hàng trăm tỷ đồng

Pháp luật

00:09:12 16/02/2025

Ngày đầu xử lý 6 nhóm hành vi giao thông: Loạt tài xế xe khách bị xử phạt

Tin nổi bật

23:40:09 15/02/2025

Ukraine muốn có đội quân 1,5 triệu người nếu không được vào NATO

Thế giới

23:37:25 15/02/2025

Treo thưởng hơn 1,65 tỷ đồng tìm "họa sĩ bốn chân" mất tích bí ẩn

Lạ vui

23:32:18 15/02/2025

Lee Min Ho bị chê già chát, bom tấn mới phá nát nguyên tác gây thất vọng toàn tập

Phim châu á

23:22:34 15/02/2025

Nóng nhất phòng vé: Phim Thu Trang chễm chệ Top 1, đá văng cái tên đình đám này

Hậu trường phim

23:17:35 15/02/2025

Phim Việt giờ vàng bị chê "làm ra chỉ để quảng cáo nước mắm và nhẫn cưới"

Phim việt

23:03:18 15/02/2025

Động thái bất ngờ của Kim Woo Bin - Shin Min Ah ngày Valentine giữa nghi vấn chia tay

Sao châu á

22:57:03 15/02/2025

Con trai massage cho mẹ để lấy tiền tiêu vặt: Giới hạn giữa mẹ và con trai

Netizen

22:50:32 15/02/2025

(Review) Captain America: Thế giới mới - 'Căng' nhưng chưa đủ 'thấm'

Phim âu mỹ

22:46:38 15/02/2025

Ứng dụng AI sinh trắc học trong bảo vệ thông tin cá nhân

Ứng dụng AI sinh trắc học trong bảo vệ thông tin cá nhân Sản phẩm giá rẻ đáng chờ đợi nhất từ Apple

Sản phẩm giá rẻ đáng chờ đợi nhất từ Apple

Các nhà khoa học lần đầu tạo ra loại pin mới, giúp robot có thể tích trữ năng lượng lâu dài như chất béo của con người

Các nhà khoa học lần đầu tạo ra loại pin mới, giúp robot có thể tích trữ năng lượng lâu dài như chất béo của con người Robot kiểm soát chất lượng thay con người

Robot kiểm soát chất lượng thay con người

Robot thay con người từ việc thủ công đến trí tuệ

Robot thay con người từ việc thủ công đến trí tuệ Robot và AI đẩy hàng triệu người vào nguy cơ thất nghiệp

Robot và AI đẩy hàng triệu người vào nguy cơ thất nghiệp Thú cưng sở hữu 'face ID', hợp đồng bảo hiểm riêng

Thú cưng sở hữu 'face ID', hợp đồng bảo hiểm riêng Nữ sinh "điên cuồng" ra rạp xem Na Tra 31 lần trong 8 ngày bị chê phung phí, người cha tiết lộ nguyên nhân đau lòng phía sau

Nữ sinh "điên cuồng" ra rạp xem Na Tra 31 lần trong 8 ngày bị chê phung phí, người cha tiết lộ nguyên nhân đau lòng phía sau Người mẫu Xuân Mai đột ngột qua đời ở tuổi 29

Người mẫu Xuân Mai đột ngột qua đời ở tuổi 29 Phát hiện bộ xương người dưới suối khi đi bắt cá

Phát hiện bộ xương người dưới suối khi đi bắt cá Bố chồng đi họp lớp mang về túi bóng đen, con dâu nhìn thấy 1 thứ bên trong thì giận tím mặt: "Sao bố làm thế?"

Bố chồng đi họp lớp mang về túi bóng đen, con dâu nhìn thấy 1 thứ bên trong thì giận tím mặt: "Sao bố làm thế?" Tiểu thư Doãn Hải My gây sốt với visual xinh hết nấc hẹn hò Văn Hậu, được ví với loạt nữ thần showbiz Hàn

Tiểu thư Doãn Hải My gây sốt với visual xinh hết nấc hẹn hò Văn Hậu, được ví với loạt nữ thần showbiz Hàn Mẹ chồng bênh vực con trai ngoại tình, nàng dâu cay đắng vạch trần sự thật động trời khiến cả nhà sụp đổ

Mẹ chồng bênh vực con trai ngoại tình, nàng dâu cay đắng vạch trần sự thật động trời khiến cả nhà sụp đổ 1 nam diễn viên khiến 8 giám khảo nổi giận đuổi khỏi sân khấu ngay trên sóng truyền hình, biết lý do không ai bênh nổi

1 nam diễn viên khiến 8 giám khảo nổi giận đuổi khỏi sân khấu ngay trên sóng truyền hình, biết lý do không ai bênh nổi Hồng Đào nói thẳng về Ngọc Trinh: "Tôi ở trong nghề quá lâu để nhìn người"

Hồng Đào nói thẳng về Ngọc Trinh: "Tôi ở trong nghề quá lâu để nhìn người" MC Huyền Trang Mù Tạt khoe được bạn trai cầu thủ "ting ting" dịp Valentine, nhìn con số mà sốc ngang

MC Huyền Trang Mù Tạt khoe được bạn trai cầu thủ "ting ting" dịp Valentine, nhìn con số mà sốc ngang Vợ ở nước ngoài ngỡ ngàng thấy ảnh cưới của chồng với người phụ nữ khác

Vợ ở nước ngoài ngỡ ngàng thấy ảnh cưới của chồng với người phụ nữ khác Báo Trung đưa tin về một chủ quán phở Hà Nội vì quá giống "thiên hậu" Cbiz, nhan sắc thế nào khiến nghìn người xôn xao?

Báo Trung đưa tin về một chủ quán phở Hà Nội vì quá giống "thiên hậu" Cbiz, nhan sắc thế nào khiến nghìn người xôn xao? Hoa hậu Ngọc Hân và chồng công bố tin vui đúng ngày Lễ Tình nhân

Hoa hậu Ngọc Hân và chồng công bố tin vui đúng ngày Lễ Tình nhân Sao nam Việt ngã lăn quay, đau đớn quằn quại trước cửa nhà bạn gái đúng Valentine, kết cục như phim

Sao nam Việt ngã lăn quay, đau đớn quằn quại trước cửa nhà bạn gái đúng Valentine, kết cục như phim Lễ tiễn biệt Từ Hy Viên: Gia đình ca hát vui vẻ, chồng Hàn gầy rộc sút hơn 7 kg sau biến cố

Lễ tiễn biệt Từ Hy Viên: Gia đình ca hát vui vẻ, chồng Hàn gầy rộc sút hơn 7 kg sau biến cố Valentine "chơi lớn" cỡ này: Vợ chồng đội trưởng tuyển Việt Nam "flex" sổ đỏ căn biệt thự bạc tỷ 3 tầng bề thế

Valentine "chơi lớn" cỡ này: Vợ chồng đội trưởng tuyển Việt Nam "flex" sổ đỏ căn biệt thự bạc tỷ 3 tầng bề thế "Cam thường" check nhan sắc thật của Doãn Hải My khi "trốn con" hẹn hò lãng mạn cùng Văn Hậu: Có khác ảnh tự đăng?

"Cam thường" check nhan sắc thật của Doãn Hải My khi "trốn con" hẹn hò lãng mạn cùng Văn Hậu: Có khác ảnh tự đăng? Sao Việt đón Valentine: Hồ Ngọc Hà "trốn con", Lệ Quyên nhận quà bất ngờ

Sao Việt đón Valentine: Hồ Ngọc Hà "trốn con", Lệ Quyên nhận quà bất ngờ