AI kiềm chế người nóng giận

Thuật toán AI được Facebook thử nghiệm có thể phát hiện những cuộc tranh cãi trong hội nhóm, sau đó báo cáo cho quản trị viên để họ kịp thời can thiệp.

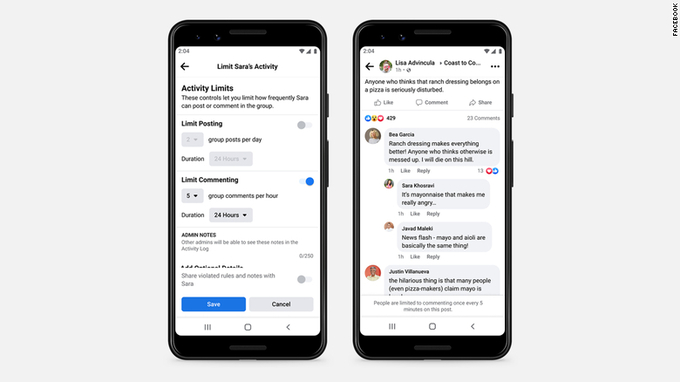

Theo CNN , Facebook mới tung ra một số phần mềm hỗ trợ hơn 70 triệu quản trị viên trong các hội nhóm trên nền tảng của mình. Trong đó, hệ thống AI mới được Facebook phát triển có thể phát hiện các vụ xung đột, cãi vã trên các hội nhóm. Công cụ “cảnh báo xung đột” dựa trên thuật toán AI sẽ thông báo đến các quản trị viên của nhóm về một nội dung “gây tranh cãi” hoặc “không lành mạnh”. Mạng xã hội ngày có 2,85 tỷ người dùng hàng tháng với khoảng 1,8 tỷ người đang hoạt động trong hàng chục triệu nhóm khác nhau.

Công cụ AI cho phép quản trị viên phát hiện nhanh các cuộc tranh cãi sắp nổ ra trong nhóm và hạn chế thời gian bình luận của các thành viên.

Trong nhiều năm, các nền tảng như Facebook và Twitter ngày càng dựa vào AI để xác định phần lớn những gì người dùng trực tuyến chia sẻ bằng các công cụ phát hiện câu chữ có tính chất gây thù hận trên dòng thời gian. Điều này có thể hỗ trợ các nhà quản lý hội nhóm dễ dàng hơn trong việc kiểm duyệt cũng như can thiệp kịp thời để tránh các xung đột không đáng có.

Tuy nhiên, đôi lúc AI vẫn khá lúng túng trong việc hiểu được sự tinh tế của ngôn ngữ trong những ngữ cảnh khác nhau. Hơn nữa, hệ thống kiểm duyệt bí mật của AI cũng có thể khiến người dùng cảm thấy bị tổn thương. Phát ngôn viên của Facebook cho biết AI của công ty sẽ sử dụng một số tín hiệu từ các cuộc trò chuyện để xác định thời điểm gửi cảnh báo xung đột, bao gồm thời gian trả lời bình luận và lượng bình luận trên một bài đăng. Ông cho biết một số quản trị viên đã thiết lập cảnh báo từ khóa có thể phát hiện các chủ đề có thể dẫn đến tranh luận.

Video đang HOT

Nếu một quản trị viên nhận được cảnh báo xung đột, họ có thể thực hiện các hành động làm chậm các cuộc trò chuyện với hi vọng làm dịu người dùng. Những động thái này có thể bao gồm hạn chế tạm thời tần suất đăng bài bình luận của một số thành viên trong nhóm và xác định tốc độ nhận xét có thể được thực hiện trên các bài đăng cá nhân.

Trong một cuộc tranh cãi giả mà Facebook thực hiện, một người dùng đã nóng giận với những từ ngữ tranh cãi khó nghe, như “những con chó của người khác”, “im đi, thật ngu ngốc”, “nếu điều vô nghĩa này xảy ra, tôi sẽ rời khỏi nhóm”… Một thông báo sẽ được gửi đến quản trị viên với thanh tiêu đề: “Cảnh báo kiểm duyệt”. Bên dưới là những từ khoá có liên quan đến vấn đề đang được tranh cãi. Tiếp đến là một khung cho phép quản trị viên cài đặt thời gian hạn chế bình luận với các tài khoản. Ngoài ra công cụ này còn cho phép hạn chế bình luận của một thành viên theo các chủ đề trong khoảng thời gian tính bằng ngày hoặc thậm chí nhiều năm.ÂI

Công cụ này vẫn đang trong giai đoạn thử nghiệm, Facebook chưa tuyên bố thời gian phát hành chính thức cho người dùng toàn cầu.

Con người có xu hướng lợi dụng AI

Một số nghiên cứu chỉ ra rằng con người có xu hướng chống đối, lợi dụng AI vì cho rằng đó là những "con bot" không có tri giác.

Trí tuệ nhân tạo đang dần bắt kịp con người khi các thuật toán có thể liên tục đánh bại con người trong các trò chơi, tạo ra hình ảnh khuôn mặt, viết báo và thậm chí là lái xe tốt hơn hầu hết thanh thiếu niên.

Nhưng AI vẫn chưa hoàn hảo. Lấy Woebot làm ví dụ.

Woebot là một ứng dụng AI trên smartphone cung cấp dịch vụ tư vấn, sử dụng hình thức đối thoại để hướng dẫn người dùng các kỹ thuật cơ bản của liệu pháp nhận thức - hành vi. Tuy nhiên, nhiều nhà tâm lý học nghi ngờ liệu một thuật toán AI có đủ khả năng thể hiện sự đồng cảm cần thiết để làm cho liệu pháp hoạt động hiệu quả hay không.

"Những ứng dụng này thực sự rất thiếu một thành phần thiết yếu trong việc trị liệu, đó là mối quan hệ giao tiếp", Linda Michaels, một nhà trị liệu tại Chicago, đồng chủ tịch của Mạng lưới Hành động Trị liệu Tâm lý, nói với The Times .

Tất nhiên, sự đồng cảm là một con đường hai chiều và con người chúng ta thường không thể hiện nhiều điều đó cho những những thứ như AI. Nhiều nghiên cứu đã phát hiện ra rằng con người thường không sẵn sàng hợp tác với AI trong nhiều tình huống, trong khi ít có khả năng làm như vậy hơn nếu bot là một người thực sự.

Ophelia Deroy, nhà triết học tại Đại học Ludwig Maximilian, ở Munich, cho biết: "Có vẻ còn thiếu điều gì đó liên quan đến sự tương tác qua lại. Về cơ bản, chúng ta sẽ cư xử với một người lạ còn tốt hơn với AI".

Trong một nghiên cứu gần đây, Tiến sĩ khoa học thần kinh Deroy và các đồng nghiệp đã tìm hiểu lý do tại sao lại như vậy. Các cuộc thử nghiệm tiến hành ghép các đối tượng là con người và bot AI với các người chơi bí mật, sau đó mỗi cặp sẽ chơi một trong một loạt các trò chơi cổ điển như Trust, Prisoner's Dilemma, Chicken và Stag Hunt, cũng như trò chơi mà họ tạo ra có tên là Reciprocity nhằm đánh giá và khen thưởng sự hợp tác.

Con người thường thể hiện ít nghĩa vụ đạo đức, kém hợp tác hơn khi tiếp xúc với AI.

Sự chống đối AI thường được cho là phản ánh sự thiếu tin tưởng. Tiến sĩ Deroy và các đồng nghiệp của bà đưa ra một kết luận khác rằng mọi người ít có khả năng hợp tác với bot ngay cả khi bot rất muốn hợp tác. Việc này không phải do chúng ta không tin tưởng AI mà là do chúng ta biết rằng bot được tạo ra để nghe lời, là một kẻ ngây thơ, vì vậy con người có xu hướng lợi dụng nó.

Tiến sĩ Deroy nói: "Những người tham gia không chỉ có xu hướng không đáp lại ý định hợp tác của các trí tuệ nhân tạo, mà còn phản bội lòng tin của các bot, họ không chia sẻ khi mắc sai lầm trong trò chơi với các bot, trong khi sẵn sàng làm như vậy với con người". Deroy nói thêm, "Bạn đơn giản chỉ làm ngơ AI và không có cảm giác rằng bạn đã vi phạm bất kỳ nghĩa vụ chung nào".

Điều này có thể có ý nghĩa trong thế giới thực. Khi chúng ta nghĩ về AI, chúng ta có xu hướng nghĩ về Alexa và Siri, những trợ lý ảo với thời gian dài tiếp xúc hoàn toàn có khả năng hình thành một loại mối quan hệ thân mật nào đó. Nhưng trên thực tế, hầu hết các tương tác của chúng ta với AI sẽ là những cuộc gặp gỡ một lần, và thường là không lời. Hãy tưởng tượng bạn đang lái xe trên đường cao tốc và một chiếc ôtô làn bên đang muốn vượt sang phía trước bạn. Nếu nhận thấy rằng chiếc xe bên cạnh là phương tiện không người lái, bạn sẽ ít có khả năng cho nó vượt lên. Và nếu thuật toán AI không tính đến hành vi xấu này của con người, một vụ tai nạn có thể xảy ra sau đó.

Tiến sĩ Deroy nói: "Điều duy trì sự hợp tác trong xã hội ở bất kỳ quy mô nào là việc thiết lập các chuẩn mực nhất định. Chức năng xã hội của cảm giác tội lỗi chính xác là thứ khiến mọi người tuân theo các chuẩn mực xã hội và khiến họ phải thỏa hiệp, hợp tác với người khác. Tuy nhiên chúng ta không tiến hóa để có các chuẩn mực xã hội hoặc đạo đức với các sinh vật không có tri giác như AI".

Cũng có những hậu quả tương tự đối với AI. "Nếu mọi người đối xử tệ với nó, và nó đã được lập trình để học hỏi từ những gì nó trải qua", ông nói. "Một AI được lập trình ban đầu phải nhân từ với con người trên đường sẽ không thể làm như vậy mãi, bởi vì nếu không nó sẽ bị mắc kẹt mãi mãi".

Như vậy bài kiểm tra Turing thực sự trong tương lai có thể là bài kiểm tra cơn thịnh nộ trên đường. Khi một chiếc ôtô tự lái bắt đầu bấm còi inh ỏi từ phía sau vì bạn đã tạt đầu nó, bạn sẽ biết rằng nhân loại đã đạt đến đỉnh cao của thành tựu. Đến lúc đó, hy vọng rằng liệu pháp AI sẽ đủ tinh vi để giúp những chiếc xe không người lái giải quyết các vấn đề về quản lý cơn giận của chúng.

Kính AI mở khoá được 19 smartphone Android  Chiếc kính đặc biệt được làm từ thuật toán AI có thể bẻ khoá bảo mật bằng nhận dạng khuôn mặt của hàng loạt smartphone phổ biến trên thị trường. Real AI, một nhóm được thành lập bởi Viện Nghiên cứu Trí tuệ Nhân tạo thuộc Đại học Thanh Hoa, Trung Quốc, vừa công bố kết quả nghiên cứu mới: Hàng loạt smartphone...

Chiếc kính đặc biệt được làm từ thuật toán AI có thể bẻ khoá bảo mật bằng nhận dạng khuôn mặt của hàng loạt smartphone phổ biến trên thị trường. Real AI, một nhóm được thành lập bởi Viện Nghiên cứu Trí tuệ Nhân tạo thuộc Đại học Thanh Hoa, Trung Quốc, vừa công bố kết quả nghiên cứu mới: Hàng loạt smartphone...

Sao nữ Vbiz gọi tên Quý Bình giữa đêm: Day dứt lần gặp cuối cùng, gấp rút xin lỗi vì 1 lý do05:19

Sao nữ Vbiz gọi tên Quý Bình giữa đêm: Day dứt lần gặp cuối cùng, gấp rút xin lỗi vì 1 lý do05:19 Người đẹp vừa dứt áo ra đi khỏi công ty Sen Vàng bị loại thẳng tại sơ khảo Hoa hậu Việt Nam 2024!01:55

Người đẹp vừa dứt áo ra đi khỏi công ty Sen Vàng bị loại thẳng tại sơ khảo Hoa hậu Việt Nam 2024!01:55 Đã có câu trả lời cho mối quan hệ của SOOBIN và Hoa hậu Thanh Thuỷ!04:39

Đã có câu trả lời cho mối quan hệ của SOOBIN và Hoa hậu Thanh Thuỷ!04:39 Ngân 98 nhập viện phẫu thuật gấp: Tình trạng nghiêm trọng, phải hủy liền 3 show diễn01:40

Ngân 98 nhập viện phẫu thuật gấp: Tình trạng nghiêm trọng, phải hủy liền 3 show diễn01:40 40 giây khiến AMEE bị "la ó" nghiêm trọng: Hát không được, nhảy không xong, nói chuyện thì thào00:41

40 giây khiến AMEE bị "la ó" nghiêm trọng: Hát không được, nhảy không xong, nói chuyện thì thào00:41 Những ngày cuối cùng Ốc Thanh Vân ở Úc: Thanh lý sạch đồ đạc, bật mí khoảnh khắc "giọt nước tràn ly"02:59

Những ngày cuối cùng Ốc Thanh Vân ở Úc: Thanh lý sạch đồ đạc, bật mí khoảnh khắc "giọt nước tràn ly"02:59 Đám cưới lạ nhất Trung Quốc: Chú rể ăn vụng ngay trên sân khấu, thái độ của cô dâu khi phát hiện lên hot search00:16

Đám cưới lạ nhất Trung Quốc: Chú rể ăn vụng ngay trên sân khấu, thái độ của cô dâu khi phát hiện lên hot search00:16 Thanh niên la hét thất thanh, hất văng chiếc TV xuống đất, "vị khách lạ" thình lình trườn vào phòng "ngơ ngác": Đã ai làm gì đâu!00:20

Thanh niên la hét thất thanh, hất văng chiếc TV xuống đất, "vị khách lạ" thình lình trườn vào phòng "ngơ ngác": Đã ai làm gì đâu!00:20 Phóng to đoạn clip camera an ninh quay lại 1 gia đình, cộng đồng mạng phát hiện điểm không ngờ01:03

Phóng to đoạn clip camera an ninh quay lại 1 gia đình, cộng đồng mạng phát hiện điểm không ngờ01:03 SOOBIN đã có bạn gái nhưng vẫn tích cực "đẩy thuyền" với Hoa hậu Thanh Thủy?01:07

SOOBIN đã có bạn gái nhưng vẫn tích cực "đẩy thuyền" với Hoa hậu Thanh Thủy?01:07 Cô giáo khóa cửa bỏ quên học sinh tiểu học trong lớp00:42

Cô giáo khóa cửa bỏ quên học sinh tiểu học trong lớp00:42Tin đang nóng

Tin mới nhất

Nâng cao và biến đổi hình ảnh của bạn bằng trình chỉnh sửa video trực tuyến CapCut

Cách đăng Facebook để có nhiều lượt thích và chia sẻ

Thêm nhiều bang của Mỹ cấm TikTok

Microsoft cấm khai thác tiền điện tử trên các dịch vụ đám mây để bảo vệ khách hàng

Facebook trấn áp hàng loạt công ty phần mềm gián điệp

Meta đối mặt cáo buộc vi phạm các quy tắc chống độc quyền với mức phạt 11,8 tỷ đô

Không cần thăm dò, Musk nên sớm từ chức CEO Twitter

Đại lý Việt nhập iPhone 14 kiểu 'bia kèm lạc'

Khai trương hệ thống vé điện tử và dịch vụ trải nghiệm thực tế ảo XR tại Quần thể Di tích Cố đô Huế

'Dở khóc dở cười' với tính năng trợ giúp người bị tai nạn ôtô của Apple

Xiaomi sa thải hàng nghìn nhân sự

Apple sẽ bắt đầu sản xuất MacBook tại Việt Nam vào giữa năm 2023

Có thể bạn quan tâm

Ngỡ ngàng thành phố gần như không mưa trong suốt 600 năm

Du lịch

08:17:52 17/03/2025

Phóng to thứ đặt trên giường "Hồng Hài Nhi" 2k1 và bạn gái 33 tuổi, netizen thốt lên: Nhân duyên tiền định là đây!

Netizen

08:17:07 17/03/2025

'Cha tôi người ở lại' tập 13: Ba anh em bỏ học đi kiếm tiền, gia đình gặp biến lớn

Phim việt

08:11:18 17/03/2025

Châu Âu tính đưa quân tới Ukraine, Nga cảnh báo đanh thép

Thế giới

08:07:40 17/03/2025

9 chất dinh dưỡng phụ nữ cần để khỏe mạnh và tăng tuổi thọ

Sức khỏe

08:01:43 17/03/2025

Lễ an táng Từ Hy Viên: Lộ hình ảnh gây bức xúc vì quá sơ sài, 2 con không được đến tiễn đưa mẹ

Sao châu á

07:54:26 17/03/2025

Khởi tố Chủ tịch Công ty Vinink Land

Pháp luật

07:46:26 17/03/2025

HIEUTHUHAI bị 1 nhân vật khui chuyện quá khứ, netizen đồng loạt phản ứng: "Sao kém duyên quá!"

Sao việt

07:44:24 17/03/2025

Thêm một bom tấn Soulslike quá hay chuẩn bị ra mắt, game thủ "méo mặt" vì yêu cầu về độ tuổi

Mọt game

07:08:29 17/03/2025

5 món vừa ngon lại độc đáo với tôm, để cả nhà ăn cực hấp dẫn, đem đãi khách cũng siêu hợp

Ẩm thực

06:07:45 17/03/2025

“Bí mật” phía sau thành công của startup Việt trong đại dịch Covid-19

“Bí mật” phía sau thành công của startup Việt trong đại dịch Covid-19 Người dùng cần cập nhật Google Chrome để xử lý lỗ hổng bảo mật nghiêm trọng

Người dùng cần cập nhật Google Chrome để xử lý lỗ hổng bảo mật nghiêm trọng

Samsung đang thể hiện vị thế dẫn đầu về Trí tuệ nhân tạo nhờ chiếc TV

Samsung đang thể hiện vị thế dẫn đầu về Trí tuệ nhân tạo nhờ chiếc TV Trí tuệ nhân tạo trong tìm kiếm và giao dịch email

Trí tuệ nhân tạo trong tìm kiếm và giao dịch email Người đàn ông tự ý đổi ghế trên máy bay bị phạt 2 triệu đồng

Người đàn ông tự ý đổi ghế trên máy bay bị phạt 2 triệu đồng

Tài xế tử vong vì bị cần máy múc va trúng đầu

Tài xế tử vong vì bị cần máy múc va trúng đầu Vài tháng nay chồng không đưa đồng nào, vợ âm thầm tìm hiểu rồi xúc động trước lý do

Vài tháng nay chồng không đưa đồng nào, vợ âm thầm tìm hiểu rồi xúc động trước lý do Kim Soo Hyun bị cắt sóng tối đa, vẫn tươi cười lộ diện trên truyền hình giữa thị phi chấn động

Kim Soo Hyun bị cắt sóng tối đa, vẫn tươi cười lộ diện trên truyền hình giữa thị phi chấn động Sao Việt 17/3: Nhã Phương gọi chồng là 'hàng xóm', Minh Hằng khoe xe mới

Sao Việt 17/3: Nhã Phương gọi chồng là 'hàng xóm', Minh Hằng khoe xe mới Gil Lê - Xoài Non sơ hở là ôm hôn, tung loạt ảnh mới thân mật cỡ này!

Gil Lê - Xoài Non sơ hở là ôm hôn, tung loạt ảnh mới thân mật cỡ này! Mỹ nhân cổ trang đẹp nhất Trung Quốc hiện tại: Nhan sắc thắng đời 100-0, Lưu Diệc Phi cũng phải lép vế

Mỹ nhân cổ trang đẹp nhất Trung Quốc hiện tại: Nhan sắc thắng đời 100-0, Lưu Diệc Phi cũng phải lép vế Nam diễn viên Bao Thanh Thiên tử vong bất thường ở nhà riêng, cảnh sát phát hiện thi thể vì 1 mùi nồng nặc

Nam diễn viên Bao Thanh Thiên tử vong bất thường ở nhà riêng, cảnh sát phát hiện thi thể vì 1 mùi nồng nặc Trọn vẹn không gian lễ cưới của H'Hen Niê và ông xã, 1 điểm khác lạ chưa từng có trong Vbiz!

Trọn vẹn không gian lễ cưới của H'Hen Niê và ông xã, 1 điểm khác lạ chưa từng có trong Vbiz! "Quý Bình không cho tôi gặp vợ và con trai"

"Quý Bình không cho tôi gặp vợ và con trai" Mối quan hệ bất chính và sự giằng xé của cựu trung úy công an giết người tình

Mối quan hệ bất chính và sự giằng xé của cựu trung úy công an giết người tình Vụ tìm ân nhân cho vay 8 chỉ vàng: Đã tìm thấy nhau sau 17 năm, "chủ nợ" nói lý do không đi tìm

Vụ tìm ân nhân cho vay 8 chỉ vàng: Đã tìm thấy nhau sau 17 năm, "chủ nợ" nói lý do không đi tìm Diva Hồng Nhung lập di chúc ở tuổi 55

Diva Hồng Nhung lập di chúc ở tuổi 55 Livestream về lùm xùm Kim Soo Hyun ngày 15/3: Lộ bức ảnh tài tử "cởi trần rửa bát", mẹ Kim Sae Ron đưa ra 7 yêu cầu cực căng

Livestream về lùm xùm Kim Soo Hyun ngày 15/3: Lộ bức ảnh tài tử "cởi trần rửa bát", mẹ Kim Sae Ron đưa ra 7 yêu cầu cực căng Tài tử Việt hết thời U60 lại "gây sốt", nhận hợp đồng quảng cáo liền tay vẫn giữ 1 nguyên tắc

Tài tử Việt hết thời U60 lại "gây sốt", nhận hợp đồng quảng cáo liền tay vẫn giữ 1 nguyên tắc Nữ nghệ sĩ U60 chưa chồng con, phải mổ tim mới sống được: Lúc nào tôi cũng phải cầm điện thoại

Nữ nghệ sĩ U60 chưa chồng con, phải mổ tim mới sống được: Lúc nào tôi cũng phải cầm điện thoại Phóng viên đầu tiên bóc Kim Soo Hyun - Kim Sae Ron hẹn hò qua đời đột ngột

Phóng viên đầu tiên bóc Kim Soo Hyun - Kim Sae Ron hẹn hò qua đời đột ngột