Meta tạo mô hình AI chuyên phục vụ toán học, lập trình và suy luận

Meta vừa hé lộ một bước tiến mới đầy hứa hẹn trong lĩnh vực trí tuệ nhân tạo : mô hình 2-simplicial Transformer .

Dân toán học sẽ dễ dàng hơn khi có AI là trợ lý

Đây không chỉ là một mô hình AI thông thường, mà là một kiến trúc được thiết kế đặc biệt để vượt trội hơn các mô hình Transformer tiêu chuẩn trong những lĩnh vực đòi hỏi sự chính xác và logic cao như toán học, lập trình và suy luận .

2-simplicial Transformer là gì?

Về cơ bản, 2-simplicial Transformer là một cải tiến so với kiến trúc Transformer truyền thống – nền tảng của hầu hết các mô hình ngôn ngữ lớn (LLM) hiện nay như ChatGPT , Gemini . Nếu các Transformer thông thường xử lý thông tin theo một “luồng” tuyến tính (hoặc dựa trên mối quan hệ giữa từng cặp token riêng lẻ), thì 2-simplicial Transformer mang đến một cách tiếp cận phức tạp hơn:

Trước hết là xử lý các mối quan hệ “cấp cao hơn”. Cái tên “2-simplicial” gợi ý rằng mô hình này không chỉ nhìn vào mối quan hệ giữa hai phần tử (ví dụ: hai từ, hai token) mà còn xem xét mối quan hệ giữa ba hoặc nhiều hơn các phần tử trong dữ liệu. Hãy hình dung nó như việc không chỉ nhìn vào các cạnh của một hình tam giác (mối quan hệ giữa hai đỉnh), mà còn hiểu được bản thân hình tam giác đó như một khối (mối quan hệ giữa ba đỉnh).

Ngoài ra, nó cải thiện hiệu quả token. Một trong những thách thức của các LLM là quản lý token (các đơn vị ngôn ngữ nhỏ nhất mà mô hình xử lý). Việc cải thiện hiệu quả token (token efficiency) có nghĩa là mô hình có thể xử lý nhiều thông tin hơn với cùng một số lượng token, hoặc đạt được kết quả tốt hơn với ít token hơn. Điều này giúp tối ưu hóa chi phí tính toán và tăng cường khả năng xử lý các ngữ cảnh dài.

Video đang HOT

Thế mạnh của 2-simplicial Transformer

Điểm nhấn chính của mô hình này nằm ở khả năng thể hiện xuất sắc trong các tác vụ cụ thể. Chẳng hạn trong toán học. Các bài toán toán học yêu cầu sự hiểu biết sâu sắc về các mối quan hệ logic, cấu trúc và quy tắc. Kiến trúc 2-simplicial có thể giúp mô hình nắm bắt tốt hơn các mối liên kết này, dẫn đến khả năng giải quyết vấn đề toán học phức tạp hơn.

Hay trong lập trình vốn cũng đòi hỏi tư duy logic, khả năng nhận diện các mẫu (patterns) và hiểu mối quan hệ giữa các thành phần khác nhau của code. Việc cải thiện hiệu quả token và khả năng suy luận giúp mô hình này có thể tạo ra code chất lượng cao hơn, tìm lỗi tốt hơn và hiểu được cấu trúc lập trình phức tạp.

Đặc biệt hơn cả là khả năng suy luận (Reasoning), thứ vô cùng quan trọng cho mọi tác vụ AI nâng cao. Việc mô hình có thể suy luận tốt hơn nghĩa là nó có thể phân tích thông tin, đưa ra kết luận logic và giải quyết các vấn đề mà không chỉ dựa vào việc ghi nhớ các mẫu dữ liệu.

Ý nghĩa của mô hình này

Việc Meta phát triển 2-simplicial Transformer cho thấy một xu hướng quan trọng trong nghiên cứu AI: thay vì chỉ tăng kích thước mô hình, các nhà khoa học đang tìm kiếm các cải tiến kiến trúc sâu sắc hơn để nâng cao khả năng của AI trong các lĩnh vực cụ thể, đặc biệt là những lĩnh vực đòi hỏi sự chính xác, logic và khả năng suy luận cao.

Nếu thành công, 2-simplicial Transformer có thể mở đường cho thế hệ AI mới có khả năng giải quyết các bài toán khoa học, kỹ thuật và lập trình phức tạp hơn, đồng thời tối ưu hóa tài nguyên tính toán. Điều này sẽ có ý nghĩa lớn đối với việc phát triển các AI agent, các hệ thống tự động hóa và các công cụ hỗ trợ con người trong các lĩnh vực chuyên môn.

Google và hướng phát triển tương tự

Google có lịch sử lâu đời trong nghiên cứu Transformer và họ là người đã phát minh ra kiến trúc Transformer vào năm 2017. Google cũng đang khám phá nhiều cách để làm cho các LLM của mình thông minh và hiệu quả hơn.

Đầu tiên là tập trung vào hiệu quả token và suy luận. Google đã công bố các nghiên cứu về việc cải thiện hiệu quả token cho các tác vụ suy luận. Điều này bao gồm việc phát triển các chiến lược học tăng cường (RL) được điều chỉnh riêng cho suy luận trong LLM, đặc biệt là dưới các giới hạn về bộ nhớ và tính toán. Các phương pháp như S-GRPO (một biến thể ngẫu nhiên của Group Relative Policy Optimization) và T-SPMO (một phương pháp khớp tiền tố ở cấp độ token) đang được nghiên cứu để giảm mức sử dụng bộ nhớ và ổn định quá trình huấn luyện.

Google cũng đang khám phá các cách để LLM cộng tác với nhau (như trong nghiên cứu “Chain-of-Agents” của họ) để giải quyết các tác vụ yêu cầu ngữ cảnh rất dài. Thay vì cố gắng đưa tất cả các token vào một LLM duy nhất, họ để các tác nhân AI giao tiếp và tổng hợp thông tin, giúp cải thiện hiệu quả và khả năng suy luận trên các mẫu dài.

Google DeepMind đã giới thiệu các phương pháp như Differentiable Cache Augmentation, sử dụng bộ đồng xử lý để mở rộng bộ nhớ trong của LLM (cache key-value). Điều này giúp làm giàu thông tin cho mô hình, nâng cao khả năng suy luận mà không làm tăng gánh nặng tính toán trong quá trình thực thi.

OpenAI và hướng phát triển tương tự

OpenAI, với các mô hình GPT (Generative Pre-trained Transformer) đã trở thành chuẩn mực, cũng liên tục tìm cách nâng cao khả năng suy luận và hiệu quả của các LLM.

OpenAI đã cho thấy rằng có nhiều không gian để cải thiện khả năng suy luận của LLM thông qua việc đầu tư tính toán một cách chiến lược, đặc biệt là thông qua các phương pháp học tăng cường (RL) được tùy chỉnh cho các tác vụ suy luận. Các mô hình như o3 và o4-mini gần đây cho thấy sự tiến bộ đáng kể trong cả khả năng suy luận và khả năng sử dụng công cụ.

Mặc dù OpenAI chưa công bố trực tiếp một kiến trúc “2-simplicial Transformer”, họ liên tục tìm cách tối ưu hóa hiệu quả token trong các mô hình của mình. Việc tối ưu hóa này là rất quan trọng vì nó ảnh hưởng trực tiếp đến chi phí vận hành API và tốc độ phản hồi của mô hình. Các nghiên cứu về suy luận đa ngôn ngữ cũng cho thấy rằng việc suy luận trong các ngôn ngữ không phải tiếng Anh có thể giảm việc sử dụng token nhưng vẫn duy trì độ chính xác.

“Sparse Transformers” và cơ chế chú ý hiệu quả hơn: Từ những ngày đầu, OpenAI đã nghiên cứu các biến thể của kiến trúc Transformer, chẳng hạn như Sparse Transformers, nhằm cải thiện cơ chế chú ý (attention mechanism) để xử lý các chuỗi dài hơn một cách hiệu quả hơn so với cơ chế chú ý tiêu chuẩn. Mặc dù không phải là “2-simplicial” theo nghĩa đen, nhưng nó cho thấy OpenAI luôn tìm cách cải thiện cách mô hình xử lý mối quan hệ giữa các token.

OpenAI ra mắt các phiên bản của mô hình GPT-4.1 mới

Mới đây, OpenAI đã ra mắt mô hình AI mới nhất GPT-4.1, cùng với các phiên bản nhỏ hơn là GPT-4.1 mini và GPT-4.1 nano với những cải tiến đáng kể về khả năng lập trình, tuân thủ hướng dẫn và hiểu ngữ cảnh dài.

Biểu tượng công cụ ChatGPT của công ty OpenAI. Ảnh: AFP/TTXVN

Theo thông báo từ nhà sản xuất ứng dụng ChatGPT nổi tiếng, các mô hình mới vượt trội hơn so với mô hình GPT-4o tiên tiến nhất trước đó của công ty trên mọi phương diện. Nhưng hiện chúng chỉ có sẵn thông qua giao diện lập trình ứng dụng (API) của OpenAI.

Với khả năng hiểu ngữ cảnh được nâng cao, các mô hình mới có thể hỗ trợ tới 1 triệu "tokens" - một thuật ngữ chỉ các đơn vị dữ liệu được xử lý bởi một mô hình AI. Các mô hình này cũng được trang bị kiến thức được cập nhật đến tháng 6/2024.

GPT-4.1 cho thấy sự cải thiện 21% so với GPT-4o và 27% so với GPT-4.5 về khả năng lập trình. Bên cạnh đó, những cải tiến trong việc tuân thủ hướng dẫn và hiểu ngữ cảnh dài cũng giúp các mô hình GPT-4.1 hoạt động hiệu quả hơn trong việc hỗ trợ các tác nhân AI (AI agent).

CEO Sam Altman chia sẻ trên nền tảng mạng xã hội X rằng kết quả đánh giá các tiêu chuẩn cho những mô hình mới là rất cao. Tuy nhiên, OpenAI muốn tập trung vào tính hữu dụng trong thế giới thực.

Theo OpenAI, các mô hình mới hoạt động với chi phí thấp hơn đáng kể so với GPT-4.5. Công ty sẽ ngừng cung cấp bản xem trước GPT-4.5 hiện có sẵn trong API vào tháng 7/2025, vì các mô hình mới mang lại hiệu suất tương đương hoặc tốt hơn.

Trước đó vào tháng 2/2025, OpenAI đã phát hành bản xem trước phục vụ mục đích nghiên cứu GPT-4.5 cho một số người dùng và nhà phát triển, đồng thời công bố kế hoạch mở rộng quyền truy cập trong những giai đoạn tiếp theo.

Trận chiến AI: 'So găng' những bộ não nhân tạo quyền lực nhất hành tinh  Các "bộ não nhân tạo" như ChatGPT, Gemini, Claude, Deepseek, Copilot hay Meta AI... đang từng bước trở thành hạ tầng cốt lõi trong nhiều lĩnh vực. Nhưng trong cuộc chơi tưởng như toàn "siêu nhân" này, mỗi mô hình lại mang những ưu thế và điểm yếu riêng. Các "ông lớn" đứng sau các mô hình AI đang so kè từng ngày,...

Các "bộ não nhân tạo" như ChatGPT, Gemini, Claude, Deepseek, Copilot hay Meta AI... đang từng bước trở thành hạ tầng cốt lõi trong nhiều lĩnh vực. Nhưng trong cuộc chơi tưởng như toàn "siêu nhân" này, mỗi mô hình lại mang những ưu thế và điểm yếu riêng. Các "ông lớn" đứng sau các mô hình AI đang so kè từng ngày,...

Người gốc Việt nổ súng ngăn vụ cướp tiệm vàng ở California01:48

Người gốc Việt nổ súng ngăn vụ cướp tiệm vàng ở California01:48 Chân dung nghi phạm 22 tuổi ám sát đồng minh của Tổng thống Mỹ Donald Trump03:08

Chân dung nghi phạm 22 tuổi ám sát đồng minh của Tổng thống Mỹ Donald Trump03:08 Phó Tổng thống Mỹ khiêng quan tài của nhà hoạt động bị ám sát01:40

Phó Tổng thống Mỹ khiêng quan tài của nhà hoạt động bị ám sát01:40 Giải mã dấu hiệu mới về sức mạnh quân sự Trung Quốc08:19

Giải mã dấu hiệu mới về sức mạnh quân sự Trung Quốc08:19 Cục diện Mỹ - Venezuela thêm phức tạp09:47

Cục diện Mỹ - Venezuela thêm phức tạp09:47 Israel chuẩn bị dội bão lửa xuống Gaza, yêu cầu Hamas đầu hàng09:46

Israel chuẩn bị dội bão lửa xuống Gaza, yêu cầu Hamas đầu hàng09:46 Bí ẩn "vật thể lạ" trên Google Maps, nghi UFO ở Nam Cực, khiến thế giới sửng sốt02:33

Bí ẩn "vật thể lạ" trên Google Maps, nghi UFO ở Nam Cực, khiến thế giới sửng sốt02:33 Tổng thống Trump dọa cho Chicago 'biết mùi vị' của Bộ Chiến tranh08:18

Tổng thống Trump dọa cho Chicago 'biết mùi vị' của Bộ Chiến tranh08:18 Thiếu niên mê lập trình trở thành vị thánh đầu tiên thuộc thế hệ Y08:56

Thiếu niên mê lập trình trở thành vị thánh đầu tiên thuộc thế hệ Y08:56 Tổng thống Trump quyết trấn áp nạn nhập cư lậu08:51

Tổng thống Trump quyết trấn áp nạn nhập cư lậu08:51 Người giết cha mẹ chồng bằng nấm tử thần lãnh 3 án chung thân tại Úc08:52

Người giết cha mẹ chồng bằng nấm tử thần lãnh 3 án chung thân tại Úc08:52Tiêu điểm

Tin đang nóng

Tin mới nhất

Philippines ứng phó ở mức cao nhất khi siêu bão Ragasa quét qua miền Bắc

Các địa phương của Trung Quốc ứng phó khẩn cấp với siêu bão Ragasa

Anh xem xét bỏ phí thị thực dành cho nhân tài toàn cầu

Triều Tiên tuyên bố sở hữu 'vũ khí bí mật', đặt mục tiêu xây dựng cường quốc hàng hải

Thổ Nhĩ Kỳ dỡ bỏ thuế bổ sung đối với nhiều mặt hàng nhập khẩu từ Mỹ

Trung Quốc siết chặt kiểm soát quà tặng bánh Trung thu xa xỉ

Làn sóng chip AI kích hoạt đợt tăng giá cổ phiếu công nghệ Trung Quốc

Israel khó đạt được mục tiêu chiến tranh và giải cứu con tin

Cú sốc mới cho chuỗi cung ứng toàn cầu

Rượu vang đặc biệt cho thú cưng gây sốt

Tổng thống Mỹ Donald Trump hối thúc đồng minh châu Âu ngừng mua dầu Nga

Nhật Bản: Ban tổ chức Triển lãm Osaka Expo 2025 kêu gọi tái sử dụng gian hàng và thiết bị

Có thể bạn quan tâm

Hai vợ chồng mắc loại ung thư giống nhau, phát hiện nhờ 1 thói quen

Sức khỏe

20:36:58 22/09/2025

Qua đêm nay 23/9/2025, 3 con giáp ĐẠP TRÚNG MỎ VÀNG, giàu lên nhanh chóng, tiền bạc rủng rỉnh, ngồi một chỗ đếm tiền

Trắc nghiệm

20:35:49 22/09/2025

Phát hoảng khi xem clip 1 Em Xinh té cầu thang

Sao việt

20:13:44 22/09/2025

Mắc bẫy lừa xuất cảnh, vừa lĩnh án tù, vừa bị trục xuất về nước

Pháp luật

20:02:38 22/09/2025

Minh tinh Gia Đình Là Số 1 đột quỵ, hôn mê 9 năm qua: Đứng trước cửa tử, chỉ có 0,01% khả năng tỉnh lại

Sao châu á

19:52:54 22/09/2025

Khoảnh khắc thót tim của Phương Ly: Suýt ngã sấp mặt, hoảng quá quên luôn kịch bản

Nhạc việt

19:40:11 22/09/2025

Chính phủ Hàn Quốc phân phát ‘phiếu tiêu dùng’ cho toàn dân

Chính phủ Hàn Quốc phân phát ‘phiếu tiêu dùng’ cho toàn dân Ai Cập tăng cường nỗ lực thúc đẩy hòa bình khu vực

Ai Cập tăng cường nỗ lực thúc đẩy hòa bình khu vực

Sau mô hình AI ban đầu gây chấn động, DeepSeek đẩy nhanh ra mắt mô hình mới

Sau mô hình AI ban đầu gây chấn động, DeepSeek đẩy nhanh ra mắt mô hình mới Grok 3 có khả năng gì mà tỷ phú Elon Musk ca ngợi là AI 'thông minh nhất Trái đất'?

Grok 3 có khả năng gì mà tỷ phú Elon Musk ca ngợi là AI 'thông minh nhất Trái đất'? Vì sao mô hình AI 'siêu việt' từ Trung Quốc khiến nhà đầu tư Mỹ bất an, cổ phiếu lao dốc?

Vì sao mô hình AI 'siêu việt' từ Trung Quốc khiến nhà đầu tư Mỹ bất an, cổ phiếu lao dốc?

WhatsApp sẽ không triển khai quảng cáo tại EU trước năm 2026

WhatsApp sẽ không triển khai quảng cáo tại EU trước năm 2026 Lầu Năm Góc ký hợp đồng trị giá 200 triệu USD với OpenAI

Lầu Năm Góc ký hợp đồng trị giá 200 triệu USD với OpenAI Lý do châu Âu tụt hậu với Mỹ và Trung Quốc trong cuộc đua công nghệ toàn cầu

Lý do châu Âu tụt hậu với Mỹ và Trung Quốc trong cuộc đua công nghệ toàn cầu Rò rỉ cơ sở dữ liệu khổng lồ: 184 triệu tài khoản bị lộ thông tin đăng nhập

Rò rỉ cơ sở dữ liệu khổng lồ: 184 triệu tài khoản bị lộ thông tin đăng nhập Google tích hợp quảng cáo trong chế độ Tìm kiếm AI

Google tích hợp quảng cáo trong chế độ Tìm kiếm AI Điều khiến giới trẻ Trung Quốc tìm đến 'bác sĩ tâm lý AI'

Điều khiến giới trẻ Trung Quốc tìm đến 'bác sĩ tâm lý AI' Sinh viên phản ứng giáo sư dùng ChatGPT soạn bài giảng

Sinh viên phản ứng giáo sư dùng ChatGPT soạn bài giảng Meta yêu cầu tòa án bác vụ kiện độc quyền của Ủy ban Thương mại liên bang Mỹ

Meta yêu cầu tòa án bác vụ kiện độc quyền của Ủy ban Thương mại liên bang Mỹ

Gã khổng lồ 'công nghệ gián điệp' NSO Group bị phạt 170 triệu USD trong vụ tấn công mạng

Gã khổng lồ 'công nghệ gián điệp' NSO Group bị phạt 170 triệu USD trong vụ tấn công mạng Trên 2.000 nhân viên kiểm duyệt nội dung cho Meta mất việc

Trên 2.000 nhân viên kiểm duyệt nội dung cho Meta mất việc Trung Quốc dùng mô hình AI của DeepSeek thiết kế chiến đấu cơ tiên tiến

Trung Quốc dùng mô hình AI của DeepSeek thiết kế chiến đấu cơ tiên tiến Mỹ: Đề xuất luật buộc các cửa hàng ứng dụng App Store kiểm tra độ tuổi người dùng

Mỹ: Đề xuất luật buộc các cửa hàng ứng dụng App Store kiểm tra độ tuổi người dùng Cha đẻ ChatGPT tiết lộ cách giúp gen Z không bị AI "cướp việc"

Cha đẻ ChatGPT tiết lộ cách giúp gen Z không bị AI "cướp việc" Mark Zuckerberg cố tình kìm hãm sự phát triển của Instagram?

Mark Zuckerberg cố tình kìm hãm sự phát triển của Instagram? AHS Krab - Kẻ lật kèo trên chiến trường mang ADN công nghệ đa quốc gia

AHS Krab - Kẻ lật kèo trên chiến trường mang ADN công nghệ đa quốc gia EU phạt Apple và Meta tổng cộng gần 800 triệu USD

EU phạt Apple và Meta tổng cộng gần 800 triệu USD

Mỹ cân nhắc áp phí 100.000 USD mỗi năm cho thị thực H-1B

Mỹ cân nhắc áp phí 100.000 USD mỗi năm cho thị thực H-1B

Tổng thống Trump cảnh báo về 'rắc rối lớn' sau khi tiêm kích Nga vi phạm không phận NATO

Tổng thống Trump cảnh báo về 'rắc rối lớn' sau khi tiêm kích Nga vi phạm không phận NATO

Xung đột Hamas - Israel: Israel không kích dữ dội thành phố Gaza

Xung đột Hamas - Israel: Israel không kích dữ dội thành phố Gaza Tổng thống Trump thay đổi chính sách thị thực H-1B: Lao động nước ngoài gấp rút trở về Mỹ

Tổng thống Trump thay đổi chính sách thị thực H-1B: Lao động nước ngoài gấp rút trở về Mỹ Lý do chính quyền Tổng thống Trump muốn kiểm soát căn cứ Bagram của Afghanistan

Lý do chính quyền Tổng thống Trump muốn kiểm soát căn cứ Bagram của Afghanistan Nhiều nước chuẩn bị công nhận nhà nước Palestine

Nhiều nước chuẩn bị công nhận nhà nước Palestine "Thánh keo kiệt" showbiz quay ngoắt 180 độ khi vợ mang bầu con trai!

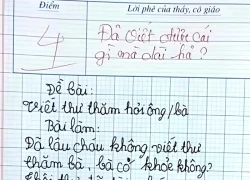

"Thánh keo kiệt" showbiz quay ngoắt 180 độ khi vợ mang bầu con trai! Bài văn viết thư hỏi thăm bà gây bão MXH, được 4 điểm nhưng dân mạng phán: "Không oan tí nào!"

Bài văn viết thư hỏi thăm bà gây bão MXH, được 4 điểm nhưng dân mạng phán: "Không oan tí nào!" Không khí lạnh sẽ làm thay đổi hướng đi, cường độ siêu bão Ragasa

Không khí lạnh sẽ làm thay đổi hướng đi, cường độ siêu bão Ragasa Nam diễn viên bị tố chia tay đòi quà khiến cả MXH chỉ trích: "Làm thế không đáng mặt đàn ông"

Nam diễn viên bị tố chia tay đòi quà khiến cả MXH chỉ trích: "Làm thế không đáng mặt đàn ông" Con trai Son Ye Jin - Hyun Bin là "bản sao nhí" của bố, đẹp đến mức ai cũng sốc

Con trai Son Ye Jin - Hyun Bin là "bản sao nhí" của bố, đẹp đến mức ai cũng sốc Á hậu Việt được bạn trai doanh nhân cầu hôn, trước khi gật đầu còn hỏi 1 câu khó lường

Á hậu Việt được bạn trai doanh nhân cầu hôn, trước khi gật đầu còn hỏi 1 câu khó lường Nam thần Việt xa rời showbiz: Sống thầm lặng bên vợ đại gia, nhan sắc tụt dốc, phát tướng khiến ai cũng tiếc hùi hụi

Nam thần Việt xa rời showbiz: Sống thầm lặng bên vợ đại gia, nhan sắc tụt dốc, phát tướng khiến ai cũng tiếc hùi hụi Phòng An ninh mạng mời Ưng Hoàng Phúc lên làm việc về MV nghi dính hình ảnh quảng cáo web cá độ

Phòng An ninh mạng mời Ưng Hoàng Phúc lên làm việc về MV nghi dính hình ảnh quảng cáo web cá độ Hồ Hoài Anh tiết lộ bí mật đằng sau chiến thắng của Đức Phúc ở Intervision 2025

Hồ Hoài Anh tiết lộ bí mật đằng sau chiến thắng của Đức Phúc ở Intervision 2025 Thông tin mới vụ anh họ sát hại bé gái 8 tuổi rồi cho vào bao tải phi tang

Thông tin mới vụ anh họ sát hại bé gái 8 tuổi rồi cho vào bao tải phi tang Bóng hồng khiến Quán quân Rap Việt bỏ showbiz: Giọng hát gây sốc, tiểu như nhà giàu hậu thuẫn hết mực cho chồng

Bóng hồng khiến Quán quân Rap Việt bỏ showbiz: Giọng hát gây sốc, tiểu như nhà giàu hậu thuẫn hết mực cho chồng Nam diễn viên Trần Quang Tiền tử vong tại nhà

Nam diễn viên Trần Quang Tiền tử vong tại nhà Diễn biến không ngờ vụ ca sĩ Lynda Trang Đài trộm cắp tài sản

Diễn biến không ngờ vụ ca sĩ Lynda Trang Đài trộm cắp tài sản 'Tử chiến trên không' cạnh tranh khốc liệt với 'Mưa đỏ' ở phòng vé, NSX nhờ đến pháp luật

'Tử chiến trên không' cạnh tranh khốc liệt với 'Mưa đỏ' ở phòng vé, NSX nhờ đến pháp luật Em bé hot nhất sân Hàng Đẫy ngồi ghế VIP, là con của chủ tịch CLB Hà Nội và "Hoa hậu nghèo nhất Việt Nam"

Em bé hot nhất sân Hàng Đẫy ngồi ghế VIP, là con của chủ tịch CLB Hà Nội và "Hoa hậu nghèo nhất Việt Nam" Ngự Trù Của Bạo Chúa bị tẩy chay vì phá nát lịch sử 2 quốc gia, "học cho tử tế rồi hẵng làm phim"

Ngự Trù Của Bạo Chúa bị tẩy chay vì phá nát lịch sử 2 quốc gia, "học cho tử tế rồi hẵng làm phim" Nam đạo diễn thu nhập mỗi tháng 1 tỷ đồng, có dãy nhà trọ 500m2: Xin bố vợ từng trái ớt, nước mắm, bột giặt

Nam đạo diễn thu nhập mỗi tháng 1 tỷ đồng, có dãy nhà trọ 500m2: Xin bố vợ từng trái ớt, nước mắm, bột giặt Anh họ sát hại bé gái 8 tuổi rồi nhét vào bao tải phi tang ở góc vườn

Anh họ sát hại bé gái 8 tuổi rồi nhét vào bao tải phi tang ở góc vườn