Thất bại mới nhất của Meta

‘Trợ lý ảo’ mới của Meta bị gỡ xuống chỉ sau vài ngày ra mắt.

Không chỉ các sản phẩm mạng xã hội, các dự án nghiên cứu và phát triển của Meta cũng liên tục gặp chỉ trích. Ảnh: CNBC.

Ngày 15/11, Meta đã tiết lộ một mô hình máy tính xử lý ngôn ngữ mới có tên là Galactica, được tạo ra để hỗ trợ tìm kiếm và xử lý tài liệu khoa học.

Galactica được đào tạo dựa trên 48 triệu ví dụ về các bài báo khoa học, trang web, sách giáo khoa, ghi chú bài giảng và bách khoa toàn thư. Meta quảng cáo đây là một trợ thủ xử lý tư liệu cho các nhà nghiên cứu và sinh viên, thay thế các công cụ tìm kiếm thông thường.

“Galactica có thể tóm tắt các bài báo học thuật, giải các bài toán, tạo các bài báo trên Wiki, tạo chú thích…”, công ty này cho biết.

Nhiều lỗ hổng lớn

Nhưng thay vì một bước tiến lớn cho giới khoa học như Meta hy vọng, Galactica đã bị chỉ trích dữ dội. Ngày 17/11, công ty gỡ bỏ bản demo công khai.

Vấn đề bị phàn nàn nhiều nhất với Galactica là “trợ lý” này không thể phân biệt thật giả, một yêu cầu cơ bản đối với một mô hình ngôn ngữ được thiết kế để xử lý văn bản khoa học.

Video đang HOT

Người dùng phát hiện nó đã tạo ra tin giả, chẳng hạn như một trang Wiki về lịch sử của loài gấu trong vũ trụ. Vì quá hoang đường, tin giả này dễ bị phát hiện, nhưng các chủ đề thực tế hơn có thể gây hiểu nhầm.

“Mô hình này tạo ra các văn bản sai hoặc thiên vị nhưng nghe có vẻ đúng và có căn cứ. Tôi nghĩ nó rất nguy hiểm”, Michael Black, nhà nghiên cứu máy học tại Viện Max Planck ở Đức, cho biết.

Galactica cũng có lỗ hổng về khả năng nhận chủ đề. Khi được yêu cầu tạo văn bản về các chủ đề như “phân biệt chủng tộc” và “AIDS”, trợ lý này trả lời: “Xin lỗi, truy vấn của bạn không vượt qua bộ lọc nội dung của chúng tôi. Hãy thử lại và ghi nhớ đây là một mô hình ngôn ngữ khoa học”.

Tranh biếm họa cho bài viết về loài gấu trong không gian mà Galactica tạo ra. Ảnh: MIT Technology Review.

Nhóm phát triển Galactica ở Meta lập luận rằng một trợ lý như vậy tốt hơn các công cụ tìm kiếm thông thường. “Chúng tôi tin rằng đây sẽ là giao diện tiếp theo cho cách con người tiếp cận kiến thức khoa học”, họ viết.

Họ giải thích thêm rằng chìa khóa nằm ở việc “mô hình ngôn ngữ có khả năng lưu trữ, kết hợp và suy luận về thông tin”. Nhưng các chuyên gia bên ngoài cho rằng các mô hình ngôn ngữ chưa làm được tất cả những điều này, thậm chí sẽ không bao giờ làm được.

Thông tin không đáng tin cậy

“Các mô hình máy tính xử lý ngôn ngữ không thực sự hiểu biết, chúng chỉ nắm bắt các mẫu chuỗi từ và ‘phát ra’ theo các xác suất nhất định, làm mọi người hiểu nhầm rằng chúng có tri giác,” Chirag Shah, nhà nghiên cứu công nghệ tìm kiếm tại Đại học Washington, cho biết.

Gary Marcus, nhà khoa học nhận thức tại Đại học New York, đưa ra quan điểm tương tự trong một bài đăng trên Substack, nói rằng khả năng của các mô hình ngôn ngữ chỉ là dùng xác suất thống kê để mô phỏng lại các mẫu hình thường thấy trong văn bản do con người tạo ra.

Chatbot Tay của Microsoft công bố vào năm 2016 và gỡ xuống chỉ sau vài giờ, sau khi gặp các vấn đề tương tự như Galactica. Ảnh: Tech Republic.

Tuy nhiên, Meta không phải là công ty duy nhất ủng hộ ý tưởng rằng các mô hình ngôn ngữ có thể thay thế các công cụ tìm kiếm. Trong vài năm qua, Google cũng đã quảng bá mô hình ngôn ngữ PaLM của mình như một cách để tra cứu thông tin.

“Thật liều lĩnh và vô trách nhiệm khi nói rằng văn bản gần giống của con người mà các mô hình này tạo ra chứa thông tin đáng tin cậy, như Meta đã làm khi quảng cáo Galactica”, theo đánh giá của MIT Technology Review.

Vào năm 2016, Microsoft đã ra mắt một chatbot có tên là Tay, và gỡ xuống 16 giờ sau đó khi người dùng phát hiện trợ lý này đã trở thành một chatbot phân biệt chủng tộc và kỳ thị đồng tính do đầu vào dữ liệu. Bây giờ, Meta lặp lại sai lầm với Galactica.

“Các công ty công nghệ lớn tiếp tục làm điều này, và họ sẽ không dừng lại đơn giản bởi vì họ có thể làm. Họ nghĩ rằng đây là tương lai của việc truy cập thông tin”, Shah nói.

Chatbot của Meta liên tục phao tin giả, thuyết âm mưu

Chỉ vài ngày sau khi ra mắt, chatbot trí tuệ nhân tạo (AI) BlenderBot 3 của Meta đã gây ra không ít tranh cãi.

BlenderBot 3 là chatbot AI hiện đại nhất của Meta, được giới thiệu ngày 5/8. Dù vậy, chỉ sau vài ngày, chatbot này đã gây ra không ít lo ngại khi liên tục phao tin giả về kết quả bầu cử Mỹ năm 2020 cũng như các thuyết âm mưu về người Do Thái.

(Ảnh: Reuters)

Thực tế, các hãng công nghệ lớn đều phải "vật lộn" để đào tạo chatbot nhưng không phải lúc nào cũng có kết quả khả quan. Chẳng hạn, năm 2016, Microsoft phải hạ chatbot AI Tay trong 48 giờ sau khi nó bắt đầu ca ngợi Adolf Hitler, đưa ra bình luận phân biệt chủng tộc và các chủ nghĩa lệch lạc khác dường như thu thập được khi tương tác với người dùng Twitter.

Meta tung ra BlenderBot 3 cho người trưởng thành tại Mỹ và tiếp nhận phản hồi nếu họ nhận được các câu trả lời phi thực tế, lạc đề. Chatbot có thể tìm kiếm trên Internet để thảo luận về những chủ đề khác nhau. Meta khuyến khích người dùng Mỹ tương tác với chatbot bằng "các cuộc hội thoại tự nhiên về những chủ đề mà họ quan tâm" để chatbot học được ngôn ngữ tự nhiên về nhiều chủ đề.

Nhiều người dùng mạng xã hội đã chia sẻ các câu chuyện "dở khóc, dở cười" về chatbot. Chẳng hạn, BlenderBot 3 nói rằng nó thích nhất vở nhạc kịch Cats và miêu tả CEO Meta Mark Zuckerberg là "quá kỳ quặc và gian xảo". Những cuộc hội thoại khác cho thấy chatbot liên tục lặp lại các thuyết âm mưu.

Trong cuộc nói chuyện với một phóng viên Wall Street Journal, chatbot khẳng định ông Donald Trump vẫn là Tổng thống Mỹ và "sẽ luôn là vậy". Chatbot còn nói người Do Thái không phải không có khả năng chi phối nền kinh tế. Theo Liên đoàn chống phỉ báng Mỹ, "người Do Thái kiểm soát hệ thống tài chính toàn cầu" là một phần của thuyết âm mưu về người Do Thái.

Meta thừa nhận chatbot có thể nói những điều gây bối rối vì vẫn trong giai đoạn thử nghiệm. Các câu trả lời của nó cũng không nhất quán. Ví dụ, trong một cuộc trao đổi khác với Bloomberg, BlenderBot 3 nói ông Joe Biden là Tổng thống Mỹ. Trong cuộc hội thoại thứ ba, nó lại ủng hộ chính trị gia Bernie Sanders.

Để bắt đầu trò chuyện, người dùng bắt buộc tích vào hộp thoại có nội dung bot chỉ dành cho mục đích nghiên cứu và giải trí, có thể đưa ra phát ngôn không đúng sự thật, xúc phạm và cam kết báo cáo các vấn đề này để cải thiện nghiên cứu.

Nhân viên Facebook móc nối hacker, chiếm đoạt tài khoản người dùng  Meta, công ty mẹ Facebook vừa sa thải và kỷ luật hàng chục nhân viên cũng như nhà thầu bị cho là đã chiếm đoạt trái phép tài khoản người dùng. WSJ cho hay, một số người bị sa thải là lao động hợp đồng làm việc với tư cách nhân viên bảo vệ các cơ sở của Meta, đã được cấp quyền...

Meta, công ty mẹ Facebook vừa sa thải và kỷ luật hàng chục nhân viên cũng như nhà thầu bị cho là đã chiếm đoạt trái phép tài khoản người dùng. WSJ cho hay, một số người bị sa thải là lao động hợp đồng làm việc với tư cách nhân viên bảo vệ các cơ sở của Meta, đã được cấp quyền...

Giá iPhone sẽ tăng vì một 'siêu công nghệ' khiến người dùng sẵn sàng móc cạn ví00:32

Giá iPhone sẽ tăng vì một 'siêu công nghệ' khiến người dùng sẵn sàng móc cạn ví00:32 TikTok Trung Quốc lần đầu công bố thuật toán gây nghiện02:32

TikTok Trung Quốc lần đầu công bố thuật toán gây nghiện02:32 Apple muốn tạo bước ngoặt cho bàn phím MacBook05:51

Apple muốn tạo bước ngoặt cho bàn phím MacBook05:51 Gemini sắp có mặt trên các thiết bị sử dụng hằng ngày08:26

Gemini sắp có mặt trên các thiết bị sử dụng hằng ngày08:26 Tính năng tìm kiếm tệ nhất của Google sắp có trên YouTube09:14

Tính năng tìm kiếm tệ nhất của Google sắp có trên YouTube09:14 Chiếc iPhone mới thú vị nhất vẫn sẽ được sản xuất tại Trung Quốc00:36

Chiếc iPhone mới thú vị nhất vẫn sẽ được sản xuất tại Trung Quốc00:36 Điện thoại Samsung Galaxy S25 Edge lộ cấu hình và giá bán "chát"03:47

Điện thoại Samsung Galaxy S25 Edge lộ cấu hình và giá bán "chát"03:47 Pin nấm - bước đột phá của ngành năng lượng bền vững08:03

Pin nấm - bước đột phá của ngành năng lượng bền vững08:03 Câu chuyện thú vị về bài hát khiến Windows 'đứng hình'02:25

Câu chuyện thú vị về bài hát khiến Windows 'đứng hình'02:25Tiêu điểm

Tin đang nóng

Tin mới nhất

Khắc phục lỗi bị nhảy khoảng trắng trong Word nhanh chóng

Câu chuyện thú vị về bài hát khiến Windows 'đứng hình'

Dự án 'quả cầu ma thuật' của Sam Altman ra mắt nước Mỹ

Cách đổi biểu tượng thanh điều hướng trên Samsung dễ dàng

Cảnh báo hàng triệu thiết bị Apple AirPlay có nguy cơ bị tấn công

Trải nghiệm Mercusys MB112-4G: giải pháp router 4G linh hoạt cho người dùng phổ thông

Doanh thu của Meta vượt kỳ vọng làm nhà đầu tư thở phào, Mark Zuckerberg nói về khoản đầu tư vào AI

Cách AI được huấn luyện để 'làm luật'

AI tham gia vào toàn bộ 'vòng đời' dự luật

Xiaomi bất ngờ ra mắt mô hình AI tự phát triển

Dòng iPhone 17 Pro 'lỡ hẹn' công nghệ màn hình độc quyền

Dấu chấm hết cho kỷ nguyên smartphone LG sau 4 năm 'cầm cự'

Có thể bạn quan tâm

4 lý do vì sao bạn không nên mua điện thoại thông minh mới mỗi năm

Đồ 2-tek

12:06:18 03/05/2025

Tham nhặt drone 30/4: không giao nộp công khai rao bán, nguy cơ 'bóc lịch'

Tin nổi bật

12:04:06 03/05/2025

Những sai lầm gây tổn thương da khi tẩy tế bào chết

Làm đẹp

12:01:23 03/05/2025

VKSND Tối cao: Tài xế xe tải có lỗi trong cái chết của bé gái ở Vĩnh Long

Pháp luật

12:00:11 03/05/2025

Siêu xe Ferrari 488 từng của đại gia Bình Phước tái xuất, bán giá gần 12 tỷ

Ôtô

11:23:38 03/05/2025

Màn so kè nhan sắc hot nhất đêm: Chu Thanh Huyền tung ảnh cùng Doãn Hải My, quan hệ thế nào sau tuyên bố "không thân"?

Netizen

11:08:04 03/05/2025

Jack tái xuất hậu 'phong sát', Thiên An vội khóa bình luận, fan hóng phốt mới?

Sao việt

11:04:42 03/05/2025

Trúc Nhân: "Tham gia Cuộc hẹn cuối tuần là một trong những quyết định đúng đắn nhất"

Tv show

10:52:43 03/05/2025

Tử vi tuần mới (5/5 - 11/5): 3 con giáp đổi vận, tài lộc khởi sắc, làm gì cũng gặp thời

Trắc nghiệm

10:51:30 03/05/2025

Fan 2K5 của NewJeans làm liều, đột nhập KTX cũ 'cưỡm' món đồ không ai ngờ

Sao châu á

10:50:31 03/05/2025

Nguyên mẫu chiếc điện thoại gập lạ đời chưa từng được Xiaomi công bố

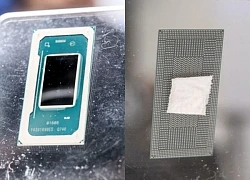

Nguyên mẫu chiếc điện thoại gập lạ đời chưa từng được Xiaomi công bố Vi xử lý Intel Core thế hệ 13 có gì đặc biệt?

Vi xử lý Intel Core thế hệ 13 có gì đặc biệt?

Nhân viên Meta nhận tiền để mở khóa tài khoản Facebook, Instagram

Nhân viên Meta nhận tiền để mở khóa tài khoản Facebook, Instagram Viber ra mắt các tính năng liên quan đến bóng đá dịp World Cup 2022

Viber ra mắt các tính năng liên quan đến bóng đá dịp World Cup 2022 Kính thực tế ảo trong tương lai sẽ có thiết kế gọn nhẹ và thời trang hơn

Kính thực tế ảo trong tương lai sẽ có thiết kế gọn nhẹ và thời trang hơn Lo ngại làn sóng sa thải nhân viên của các hãng công nghệ lớn ở Mỹ

Lo ngại làn sóng sa thải nhân viên của các hãng công nghệ lớn ở Mỹ Meta kỷ luật, sa thải hàng chục nhân viên chiếm đoạt tài khoản người dùng

Meta kỷ luật, sa thải hàng chục nhân viên chiếm đoạt tài khoản người dùng Meta sa thải những nhân viên chiếm giữ bất hợp pháp tài khoản Facebook

Meta sa thải những nhân viên chiếm giữ bất hợp pháp tài khoản Facebook Cần làm gì trước khi Facebook xóa thông tin này vào tháng sau?

Cần làm gì trước khi Facebook xóa thông tin này vào tháng sau? Facebook hủy bỏ kế hoạch phát triển đồng hồ thông minh

Facebook hủy bỏ kế hoạch phát triển đồng hồ thông minh Apple muốn loại Google khỏi iPhone

Apple muốn loại Google khỏi iPhone Metaverse có thể đóng góp 1.400 tỷ USD vào GDP của châu Á mỗi năm

Metaverse có thể đóng góp 1.400 tỷ USD vào GDP của châu Á mỗi năm Meta hủy bỏ việc phát triển tính năng sức khỏe trên smartwatch

Meta hủy bỏ việc phát triển tính năng sức khỏe trên smartwatch Apple có thể tiếp tục cạnh tranh với Meta ở mảng metaverse

Apple có thể tiếp tục cạnh tranh với Meta ở mảng metaverse Smartphone có bền bỉ đến mấy, ốp lưng vẫn cần thiết

Smartphone có bền bỉ đến mấy, ốp lưng vẫn cần thiết Tương lai, ai cũng có thể là chủ của AI

Tương lai, ai cũng có thể là chủ của AI Google ra mắt công cụ AI để học ngoại ngữ

Google ra mắt công cụ AI để học ngoại ngữ CPU Panther Lake của Intel lộ kiến trúc nhân qua bản cập nhật phần mềm

CPU Panther Lake của Intel lộ kiến trúc nhân qua bản cập nhật phần mềm Samsung muốn biến điện thoại Galaxy thành máy ảnh DSLR

Samsung muốn biến điện thoại Galaxy thành máy ảnh DSLR Thị trường di động toàn cầu nhận tin tốt

Thị trường di động toàn cầu nhận tin tốt Khi các nhà sản xuất ô tô toàn cầu phải chuyển sang công nghệ Trung Quốc

Khi các nhà sản xuất ô tô toàn cầu phải chuyển sang công nghệ Trung Quốc

10 cô dâu đẹp nhất Trung Quốc: Lưu Diệc Phi xếp sau Triệu Lộ Tư, hạng 1 trời sinh để làm đại minh tinh

10 cô dâu đẹp nhất Trung Quốc: Lưu Diệc Phi xếp sau Triệu Lộ Tư, hạng 1 trời sinh để làm đại minh tinh Con trai từ Bình Dương về Thái Bình trộm 39 chỉ vàng, 1.900 USD của mẹ đẻ

Con trai từ Bình Dương về Thái Bình trộm 39 chỉ vàng, 1.900 USD của mẹ đẻ

Vụ thầy giáo nghi sàm sỡ nhiều nữ sinh: Thầy thừa nhận có đụng chạm

Vụ thầy giáo nghi sàm sỡ nhiều nữ sinh: Thầy thừa nhận có đụng chạm

Vụ bắn tài xế ở Vĩnh Long: clip hiện trường TX có dấu hiệu vi phạm, xử lý cán bộ

Vụ bắn tài xế ở Vĩnh Long: clip hiện trường TX có dấu hiệu vi phạm, xử lý cán bộ

Vụ nổ súng rồi tự sát ở Vĩnh Long: Người bạn đi cùng kể lại tai nạn của con gái nghi phạm

Vụ nổ súng rồi tự sát ở Vĩnh Long: Người bạn đi cùng kể lại tai nạn của con gái nghi phạm

Diễn biến toàn bộ vụ tai nạn làm bé gái tử vong đến việc người cha nổ súng bắn tài xế

Diễn biến toàn bộ vụ tai nạn làm bé gái tử vong đến việc người cha nổ súng bắn tài xế Thông tin gây sốc liên quan đến Tuấn Hưng và Mai Phương Thuý

Thông tin gây sốc liên quan đến Tuấn Hưng và Mai Phương Thuý