Android Pie ‘mất tích’ trong danh sách thiết bị chạy Android

Phiên bản hệ điều hành di động mới nhất Android Pie ( Android 9) dù đã được phát hành, nhưng thật số lượng người dùng không nhiều.

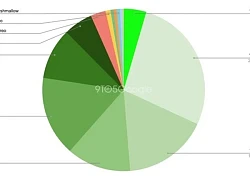

Theo Neowin, báo cáo của Google cung cấp cái nhìn về phiên bản hệ điều hành phổ biến dựa trên số lượng thiết bị hoạt động đã được sử dụng để truy cập vào Google Play Store. Các thiết bị chạy phiên bản ROM tùy chỉnh sẽ không nằm trong danh sách.

Dưới đây là danh sách liệt kê từ báo cáo của Google:

Pixel 3 không đủ giúp Android 9.0 Pie lọt vào danh sách phân bổ Android

Không ngạc nhiên khi Android 8.x Oreo một lần nữa ghi nhận tăng trưởng lớn nhất với mức tăng tổng cộng 6,9%, giúp phiên bản này lên đến 21,5% thị phần người dùng Android sau gần 11 tháng kể từ khi phát hành.

Trong khi đó, sau một thời gian thay đổi bằng 0%, tổng mức sử dụng Android 7.x đã giảm 2,6% với phần lớn thuộc về phiên bản 7.0. Bên cạnh đó, gần như các phiên bản chính của Android được theo dõi đều ở mức giảm, ngoại trừ Ice Cream Sandwich vẫn giữ nguyên.

Đáng chú ý, phiên bản mới nhất là Android 9.0 Pie vẫn chưa thể có được thị phần tối thiểu 0,1%, dù rằng trên thị trường đã có nhiều mẫu điện thoại Android trang bị sẵn nền tảng này khi vừa xuất xưởng.

Theo Báo Mới

Video đang HOT

Google đã làm cho zoom số của Pixel 3 đẹp gần bằng zoom quang như thế nào

Super Res Zoom là tính năng zoom số của Pixel 3 và Pixel 3 XL. Bình thường khi nhắc tới zoom số chúng ta thường hay khinh bỉ nó vì hình chắc chắn sẽ vỡ nát, nhưng Google sử dụng cách ghép nhiều khung ảnh lại với nhau để tạo ra một tấm ảnh độ phân giải lớn hơn lúc bạn zoom.

Cũng vì lý do này mà nếu bạn dùng tính năng zoom của Pixel 3 thì ảnh sẽ ngon hơn so với khi bạn đã chụp rồi mới crop sát lại chủ thể bạn cần tập trung. Google nói Super Res Zoom của họ có thể cho chất lượng đạt gần bằng cơ chế zoom quang học 2x trên những chiếc điện thoại khác.

Thách thức của zoom số

Zoom số khó ở chỗ bạn cần 1 thuật toán tốt. Zoom số bắt đầu bằng việc zoom vào 1 khu vực trên tấm ảnh, khu vực này sẽ có độ phân giải thấp hơn so với khi bạn chụp không zoom. Kế tiếp, máy phải dựng lại các chi tiết bị mất ở mức đủ tốt khi ảnh bị phóng to trở ra trước khi lưu xuống bộ nhớ.

Thuật toán truyền thống thường dùng cho zoom số là nội suy tuyến tính, tức là máy sẽ cố gắng dựng lại các chi tiết thiếu bằng cách sử dụng những pixel mới hơi mờ và nhìn khá bệt, phẳng, thêm những pixel này vào ảnh rồi lưu xuống bộ nhớ.

Trong khi đó, các thuật toán hiện đại ngày nay sử dụng machine learning (Google dùng một nghiên cứu tên là RAISR để chạy). Thuật toán mới sẽ nhận biết được viền và một số bề mặt nhất định của các điểm ảnh rồi phóng to nó ra. Tất nhiên machine learning cũng không thể nào phục hồi nguyên dạng và đầy đủ, tự nhiên được. Trên Pixel 2 và Pixel 3, Google vẫn dùng RAISR nhưng cho mục đích tăng chất lượng mà thôi, còn tính năng zoom 2x, 3x Super Res Zoom thì sử dụng cơ chế multi frame.

![]()

Ảnh zoom so sánh giữa Pixel 2 và Pixel 3

Ngoài ra, nhiếp ảnh còn khó ở chỗ bản thân ảnh khi chụp lại bằng cảm biến là đã có thông tin bị mất mát rồi. Hãy nhìn bức ảnh bên dưới, khi dữ liệu được cảm biến ghi nhận, máy phải dùng phần mềm để đoán xem màu của những chỗ bị trống là gì.

Ở ngoài cùng bên trái là lưới Bayer, bộ lưới lọc được lắp lên trên cảm biến ảnh. Mỗi ô sẽ ghi nhận được 1 màu khác nhau trong số ba màu cơ bản là R, G, B. Điều này cũng có nghĩa là khi kết xuất dữ liệu xuống file, ô đỏ chỉ biết vị trí của ô đỏ, xanh chỉ biết xanh. Những ô nằm giữa thì không biết, đó chính là tình trạng missing information.

Từ lâu người ta đã làm ra thuật toán tính giá trị trung bình của các điểm ảnh xung quanh để tìm ra giá trị của pixel không ghi nhận thông tin. Theo Google, 2/3 tấm ảnh bạn chụp thực chất là ảnh được dựng lại chứ không phải giá trị gốc của ánh sáng. Kĩ thuật này gọi là demoisac.

Dù các thuật toán demoisac ngày nay đã trở nên phức tạp hơn và chính xác hơn nhưng về cơ bản kết quả vẫn chưa thật sự tốt. Với cảm biến di động vốn có kích thước nhỏ, lượng thông tin ghi nhận được đã ít lại còn bị mất nên khá là khó khăn. Các máy chụp ảnh DSLR thì đỡ hơn do cảm biến lớn hơn, kích thước mỗi pixel to hơn nên ghi nhận được nhiều thông tin hơn, nhờ vậy thuật toán xử lý tốt hơn.

Khi bạn pinch to zoom, thuật toán lại càng phải đoán nhiều thông tin hơn nữa.

Sử dụng multi frame để giải quyết vấn đề

1 khung hình không chứ đủ thông tin, nhưng nếu dùng nhiều khung hình chụp liên tiếp nhau và hơi xê dịch nhau một tí thì sao? Đây là cách mà các nhiếp ảnh gia đã tạo ra ảnh HDR. Thuật toán HDR rất tốt đang dùng cho Pixel hiện nay cũng như Nexus ngày xưa cũng hoạt động dựa trên cùng nguyên lý.

Khoảng hơn 10 năm nay các cơ quan vũ trụ đã sử dụng kĩ thuật gọi là drizzle, tức gom hình ảnh từ nhiều góc khác nhau để tạo ra một tấm ảnh lớn hơn. Nó có thể tạo ra ảnh chất lượng ngang với lúc chụp zoom quang 2x hoặc 3x trong điều kiện đủ sáng. Và thay vì phải đi tính toán, suy luận để ra được giá trị màu của các ô bị thiếu thì giờ chúng ta tổng hợp nó trực tiếp từ nhiều tấm ảnh khác nhau luôn cho nhanh.

Trong ví dụ bên trên, mỗi tấm ảnh hơi xê dịch lên trên, sang trái, sang phải, xuống dưới 1 pixel. Dần dần các pixel bị thiếu thông tin sẽ được "điền" vào, vậy là không cần phải chạy thuật toán demosaic nữa. Một số camera đời mới với tính năng Sensor Shift cũng đã áp dụng kĩ thuật tương tự để chụp ảnh nhưng yêu cầu phải có tripod để đảm bảo ảnh không bị dịch chuyển nhiều. Kĩ thuật này còn có một tên gọi khác là microstepping.

Kĩ thuật này tính ra cũng khó, vì nếu chủ thể chuyển động nhanh, rung tay làm máy dịch chuyển... thì khi cảm biến dịch chuyển sẽ chụp một khung ảnh quá khác biệt so với khung gốc, lúc ghép lại không còn chính xác nữa. Đó là lý do vì sao trước giờ microstepping chỉ được áp dụng trong phòng lab, trong những điều kiện chụp ảnh được kiểm soát ngặt nghèo.

Cách giải quyết của Google

Để ghép khung ảnh một cách hiệu quả và có thể tạo ra giá trị RGB cho mỗi pixel mà không cần chạy demosaic, Google phát triển một phương pháp tích hợp dữ liệu xuyên suốt nhiều khung ảnh dựa trên viền của chủ thể. Cụ thể hơn, thuật toán AI sẽ phân tích các khung hình và điều chỉnh cách ghép tùy tình huống. Điều này làm ảnh không bị mờ, nhòe, ít noise, bù lại độ phân giải giảm đi một chút. Đây là sự đán đổi cần thiết và Google đã điều chỉnh cách ghép ảnh dựa theo viền để tạo ra sự cân bằng giữa độ nét và độ noise cũng như sự sai lệch ảnh.

![]()

Đánh đổi giữa chất lượng, độ nét với noise, chi tiết

Để giúp thuật toán xử lý được các cảnh có chủ thể chuyển động, ví dụ như người hay xe đang di chuyển, Google phát triển thêm một mô hình phát hiện và giảm thiểu sự sai khác. Cách mô hình này hoạt động đó là chọn 1 khung hình làm khung tham chiếu, sau đó trộn thông tin từ các khung khác vào đây với điều kiện dữ sắp được trộn không phải là đối tượng đang di chuyển. Bằng cách này, Google loại bỏ được tình trạng bóng ma hay còn gọi là mờ chuyển động.

![]()

Ảnh ghép từ nhiều khung bị mờ, và ảnh ghép sử dụng model của Google

Theo Tinh Te

Adaptive Battery tự bật trên Android Pie vì "thử nghiệm nội bộ" của Google  Google chính thức công bố Android 9.0 Pie vào tháng 8 năm nay, và ngay sau đó đã phát hành bản cập này cho các smartphone Pixel được hỗ trợ. Android Pie sở hữu nhiều tính năng mới, như điều hướng bằng cử chỉ mới, cài đặt nhanh được thiết kế lại và hơn thế nữa. Không ngạc nhiên, khi trí tuệ nhân...

Google chính thức công bố Android 9.0 Pie vào tháng 8 năm nay, và ngay sau đó đã phát hành bản cập này cho các smartphone Pixel được hỗ trợ. Android Pie sở hữu nhiều tính năng mới, như điều hướng bằng cử chỉ mới, cài đặt nhanh được thiết kế lại và hơn thế nữa. Không ngạc nhiên, khi trí tuệ nhân...

Người dùng Galaxy tại Việt Nam bắt đầu nhận One UI 703:50

Người dùng Galaxy tại Việt Nam bắt đầu nhận One UI 703:50 One UI 7 chậm chạp khiến Samsung mất vị thế dẫn đầu thế giới Android09:37

One UI 7 chậm chạp khiến Samsung mất vị thế dẫn đầu thế giới Android09:37 Google dừng hỗ trợ, hàng triệu điện thoại Android gặp nguy hiểm08:58

Google dừng hỗ trợ, hàng triệu điện thoại Android gặp nguy hiểm08:58 Google nâng tầm Gemini với khả năng tạo video dựa trên AI08:26

Google nâng tầm Gemini với khả năng tạo video dựa trên AI08:26 Google ra mắt công cụ AI cho phép tạo video từ văn bản và hình ảnh00:45

Google ra mắt công cụ AI cho phép tạo video từ văn bản và hình ảnh00:45 TikTok Trung Quốc lần đầu công bố thuật toán gây nghiện02:32

TikTok Trung Quốc lần đầu công bố thuật toán gây nghiện02:32 Giá iPhone sẽ tăng vì một 'siêu công nghệ' khiến người dùng sẵn sàng móc cạn ví00:32

Giá iPhone sẽ tăng vì một 'siêu công nghệ' khiến người dùng sẵn sàng móc cạn ví00:32 Apple muốn tạo bước ngoặt cho bàn phím MacBook05:51

Apple muốn tạo bước ngoặt cho bàn phím MacBook05:51 Tính năng tìm kiếm tệ nhất của Google sắp có trên YouTube09:14

Tính năng tìm kiếm tệ nhất của Google sắp có trên YouTube09:14 Chiếc iPhone mới thú vị nhất vẫn sẽ được sản xuất tại Trung Quốc00:36

Chiếc iPhone mới thú vị nhất vẫn sẽ được sản xuất tại Trung Quốc00:36Tiêu điểm

Tin đang nóng

Tin mới nhất

Chiếc iPhone mới thú vị nhất vẫn sẽ được sản xuất tại Trung Quốc

One UI 7 kìm hãm sự phổ biến của Android 15?

Chuẩn USB từng thay đổi cả thế giới công nghệ vừa tròn 25 tuổi

Tính năng tìm kiếm tệ nhất của Google sắp có trên YouTube

Làm chủ chế độ PiP của YouTube với 3 thủ thuật ít người biết

Apple Maps hỗ trợ chỉ đường qua CarPlay tại Việt Nam

Giới công nghệ 'loạn nhịp' vì khái niệm AI PC

Android 16 sắp có thể 'chặn đứng' thiết bị USB độc hại

Gemini sắp có mặt trên các thiết bị sử dụng hằng ngày

Apple khuyên người dùng iPhone xóa trình duyệt Chrome

Windows Maps của Microsoft sắp bị 'khai tử'

ChatGPT vừa miễn phí tính năng AI cao cấp cho tất cả người dùng

Có thể bạn quan tâm

Lập Hạ: Làm 3 việc này cả năm Lộc Khí Vào Nhà, kinh doanh đắc tài, cuối năm tậu nhà sắm xe

Trắc nghiệm

2 phút trước

Katy Perry vừa hát vừa khóc vì con gặp chuyện, "réo" Lady Gaga, nói câu bất ngờ?

Sao âu mỹ

9 phút trước

Nữ rapper hot nhất nhì hiện nay bị tố kỳ thị châu Á, netizen réo tên Jennie vì 1 lý do gây phẫn nộ

Nhạc quốc tế

23 phút trước

Đúng ngày này năm xưa: Như Có Bác Trong Ngày Đại Thắng ra đời, khúc ca khải hoàn gắn liền với thời khắc lịch sử

Nhạc việt

26 phút trước

Người đàn ông tử vong dưới giếng sâu 30m

Tin nổi bật

32 phút trước

Nghi án con sát hại mẹ tại nhà riêng rồi trốn vào nhà nghỉ

Pháp luật

35 phút trước

Nam NSƯT có chiếc mũi to "kinh điển" và loạt câu nói khiến fan không thể nhịn cười

Sao việt

36 phút trước

5 phim "nhãn đỏ" gây sốc toàn cầu của mỹ nhân đẹp nhất thế giới 2025: Tra tấn khán giả!

Phim âu mỹ

38 phút trước

Vụ Vạn Hạnh Mall: Người mất chưa yên, khách đến hiện trường làm điều khó ngờ

Netizen

53 phút trước

Xabi Alonso quyết định đến Real Madrid

Sao thể thao

1 giờ trước

Grab nhận 200 triệu USD đầu tư của Booking Holdings

Grab nhận 200 triệu USD đầu tư của Booking Holdings Lo thực phẩm không an toàn, dân phố đua nhau trồng rau sạch thời 4.0

Lo thực phẩm không an toàn, dân phố đua nhau trồng rau sạch thời 4.0

Thị phần Android tháng 9/2018: Vẫn chưa thấy Android Pie xuất hiện

Thị phần Android tháng 9/2018: Vẫn chưa thấy Android Pie xuất hiện Cách bật giao diện màu tối trên YouTube cho Android

Cách bật giao diện màu tối trên YouTube cho Android Có vẻ như Samsung đã khắc phục được vấn đề khiến người dùng không hài lòng nhất về flagship của họ

Có vẻ như Samsung đã khắc phục được vấn đề khiến người dùng không hài lòng nhất về flagship của họ Cùng với Note 9, siêu phẩm Android này sẽ "thiêu rụi" iPhone X

Cùng với Note 9, siêu phẩm Android này sẽ "thiêu rụi" iPhone X Xiaomi ngừng hỗ trợ 7 mẫu điện thoại phổ biến

Xiaomi ngừng hỗ trợ 7 mẫu điện thoại phổ biến Cách Trung Quốc tạo ra chip 5nm không cần EUV

Cách Trung Quốc tạo ra chip 5nm không cần EUV Màn hình Always On là kẻ thù gây hao pin điện thoại?

Màn hình Always On là kẻ thù gây hao pin điện thoại? Sau Internet và iPhone, dự đoán của Kurzweil khiến chúng ta phải giật mình

Sau Internet và iPhone, dự đoán của Kurzweil khiến chúng ta phải giật mình Bot AI Facebook nhập vai người nổi tiếng nói chuyện tình dục với trẻ em

Bot AI Facebook nhập vai người nổi tiếng nói chuyện tình dục với trẻ em HyperOS 3 sẽ thổi luồng gió mới cho thiết bị Xiaomi

HyperOS 3 sẽ thổi luồng gió mới cho thiết bị Xiaomi Microsoft đưa tính năng Recall gây tranh cãi trở lại PC Copilot+

Microsoft đưa tính năng Recall gây tranh cãi trở lại PC Copilot+ Gmail cho iPhone vừa được Google 'lột xác' sau 4 năm

Gmail cho iPhone vừa được Google 'lột xác' sau 4 năm Những khiếu nại của người cha vụ nữ sinh tử vong ở Vĩnh Long

Những khiếu nại của người cha vụ nữ sinh tử vong ở Vĩnh Long Chủ tịch nước đặc xá cho 8.055 phạm nhân

Chủ tịch nước đặc xá cho 8.055 phạm nhân Nam diễn viên Việt bí mật đám cưới, đã có con gái đầu lòng nhưng không ai hay biết

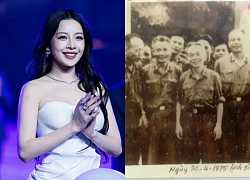

Nam diễn viên Việt bí mật đám cưới, đã có con gái đầu lòng nhưng không ai hay biết Chi Pu hé lộ tư liệu quý về ông nội, từng trực chiến cùng Đại tướng Võ Nguyên Giáp vào sáng 30/4/1975!

Chi Pu hé lộ tư liệu quý về ông nội, từng trực chiến cùng Đại tướng Võ Nguyên Giáp vào sáng 30/4/1975!

Điều tra vụ phụ huynh vào trường hành hung nữ giáo viên

Điều tra vụ phụ huynh vào trường hành hung nữ giáo viên

Chu Thanh Huyền phẫu thuật thẩm mỹ?

Chu Thanh Huyền phẫu thuật thẩm mỹ?

Vụ ma túy ở Quảng Ninh: Bạn gái kẻ trốn nã Bùi Đình Khánh bị khởi tố

Vụ ma túy ở Quảng Ninh: Bạn gái kẻ trốn nã Bùi Đình Khánh bị khởi tố CQĐT VKSND Tối cao vào cuộc vụ tai nạn liên quan con gái nghi phạm bắn người rồi tự sát

CQĐT VKSND Tối cao vào cuộc vụ tai nạn liên quan con gái nghi phạm bắn người rồi tự sát Hàng trăm tấn dầu ăn, bột canh giả đã bán cho bếp ăn khu công nghiệp

Hàng trăm tấn dầu ăn, bột canh giả đã bán cho bếp ăn khu công nghiệp Công an Vĩnh Long làm rõ thủ phạm vụ nổ súng bắn người rồi tự sát

Công an Vĩnh Long làm rõ thủ phạm vụ nổ súng bắn người rồi tự sát Cuộc sống viên mãn của nam nghệ sĩ Việt nổi tiếng với vợ hơn 15 tuổi, có 2 con riêng

Cuộc sống viên mãn của nam nghệ sĩ Việt nổi tiếng với vợ hơn 15 tuổi, có 2 con riêng